1. 什么是正则表达式和 Grammar?

我们会接触到各种各样的结构化数据: 电话号码、电子邮件地址、邮政地址、信用卡号码等等。

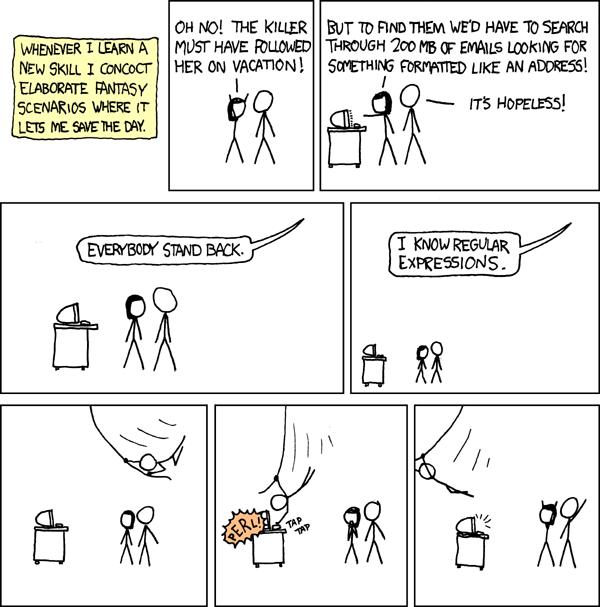

正则表达式是一种声明性的编程结构, 用来描述这些数据格式。正则表达式可以让你搜索数据, 确保输入的数据确实是真实的格式, 甚至可以提取相关的组件, 如邮政地址的邮政编码, 或日志文件条目中的时间戳。

当你需要读取和验证更复杂的结构时, 比如程序设计语言, 或者像 XML 这样的标记语言, 你可以把多个正则表达式组合成 grammar。Grammar 的作用不仅仅是简单地组合正则表达式。它们还提供生成良好的错误信息和在分析输入文本时跟踪状态的基础设施。

1.1. 使用场景

1.1.1. 搜索

正则表达式的一个常见用途是在大量数据中搜索感兴趣的模式, 例如在日志文件中查找某些消息, 在 URL 中查找特定的信息, 或者在文本中查找电话号码。在写这篇文章的时候, 我的 .bash_history 中大约有 6% 的条目涉及到使用正则表达式进行搜索。

许多命令行工具都支持某些正则表达式方言, 允许你搜索文件名、文件内容、日志、捕获的网络流量以及几乎所有你能想到的东西。大多数现代编程语言也可以很容易地使用正则表达式, 使其成为一种无处不在、不可或缺的搜索工具。

1.1.2. 验证

大多数应用程序都面临着不可信的用户输入。特别是 Web 应用程序面临着大量的不可信输入。这些输入必须在应用任何进一步的逻辑或将其存储在例如数据库中之前进行验证。

正则表达式是验证的第一步。他们使检查数字等简单的事情变得简单, 并验证输入的最小长度和最大长度。同时, 它们允许程序员进行更精确、更复杂的检查。

Web 应用程序员只需要提供一个正则表达式, 并将其与输入字段关联。然后, Web 框架可以根据所有已配置的正则表达式来验证表单输入, 并自动为终端用户生成错误信息, 这样 Web 应用程序员就不需要处理拒绝输入和重新生成表单的工作流程。

1.1.3. 解析

单独使用正则表达式不太适合解析复杂的输入数据。然而, Raku 添加了功能, 使其非常适合这项任务。这些扩展包括易于使用的回溯控制和通过命名正则表达式获得的可组合性。

一个成功的正则表达式匹配, 其结果是一个匹配对象, 它包含了所有必要的元数据, 用于从解析后的文本中提取出感兴趣的部分。 还有一些功能, 可以很容易地将匹配对象转换为抽象语法树或 AST, 一种适合在解析器之外使用的数据结构。

1.2. 正则或正则表达式

正则表达式的理论基础来自于计算机科学, 它描述了一种形式语言和自动机或形式机的层次结构, 可以识别这些语言。这些语言中, 最有限的一种语言被称为正则语言。[1]决定特定字符串是否使用常规语言需要固定的内存量和每个固定数量的计算步骤字符。

正则表达式是一种编写正则语言的形式。随着从理论计算机科学中这些概念的发展, 它们是简约的, 只允许字面量, 替换(|), 括号进行分组, 以及Kleene star[2](*)表示零次或多次重复。

早期的文本处理工具, 如 grep, sed 和 awk 都接受了正则表达式的概念, 并加入了许多方便的功能, 比如可以编写 [az] 而不是 a|b|c|d|e ….。他们提供了预定义的*字符类*、字符集、例如字母、数字、空白字符等等。他们还增加了捕获功能, 帮助提取正则表达式匹配的特定部分的字符串。

后来的实现增加了一些超出正则语言所允许的功能, 因此需要一个单独的单词。这些实现也是为了便于使用而不是理论构造的极简主义而进行优化。现在, 我们在谈论到编程语言和库中的实用(而且更强大的)实现时, 倾向于使用正则表达式。

1.3. Raku 正则表达式有什么特别之处

为了继续上一节的历史课程, Perl 是最早将正则表达式纳入其核心功能的通用编程语言之一。它从早期的正则表达式实现中借鉴了语法, 并对其进行了扩展, 使正则表达式变得更加强大和有用。很快, Perl 的特殊版本的正则表达式就成为了事实上的标准。所以很多名为兼容 Perl 的正则表达式(PCRE)的库被创建出来, 这样其他软件可以在他们自己的实现中使用 "Perl 正则表达式"。

遗憾的是, 在使正则表达式如此有用的过程中, Perl 给几乎所有的 ASCII 字符都赋予了特殊的的含义(除了按字面匹配的字符)。并且, 随着更多新的、更强大的正则表达式功能被创造出来, 这就导致了在继续保持与现有的正则表达式语法向后兼容的同时, 还需要使用一些晦涩的字符序列来实现新的功能。(?⇐pattern) 就是一个很好的例子。

Raku 正则表达式清理了这种历史上的语法包袱。它们通过允许无处不在的空白, 引入了关于哪些字符是特殊字符, 哪些不是特殊字符的规则, 以及最重要的是, 它们有一个简单、可扩展的语法, 可以通过名字来调用其他正则表达式, 从而提高来可读性。

虽然大多数语言将正则表达式视为字符串或特殊对象, 但是 Raku 正则表达式是代码; 当正则表达式在 grammar 中组合在一起时, 就像方法一样。这让你可以自由地将所有你在编程语言中习惯你的管理和重用代码的技术应用到正则表达式中: 命名空间、类、角色[3]、继承等等。

组合正则表达式的能力使得 Raku 不仅仅能解析简单的字符串格式。你可以写出使用许多小的正则表达式来解析复杂的文件格式的 grammar。实际上, Rakudo 编译器本身就使用了 grammar 来解析 Raku 源代码。

2. Raku 入门

通过阅读本书, 你可能会捡起一些东西, 了解一些基本的概念; 但如果你的目标是流畅和更深层次的理解, 你应该自己运行这些例子, 修改它们, 并进行试验。

为此, 你首先需要安装 Raku 编译器, 版本为 2017.05 或更新版本。之后, 我们将讨论如何使用它进行正则表达式实验。

如果你不愿在计算机上安装软件, 也可以使用一个在线服务来运行你的代码。在写这篇文章的时候, https://glot.io/new/raku 和 https://tio.run/#raku 支持在浏览器中运行 Raku 代码。你也可以在 https://raku.org/resources/ 上查看类似服务的最新列表。

2.1. 安装 Raku

Raku 编译器有两种: 编译器本身和 Rakudo Star。后者是一个包含编译器、zef 模块安装程序、文档和一些模块的发行版。

出于我们的目的, 你需要编译器和 zef。安装 Rakudo Star 为你提供了这两样东西, 但如果 Rakudo Star 安装程序不适合你, 或者你更喜欢更精简的安装, 你可以只安装编译器, 并根据文档安装 zef。[4]

以下是安装 Raku 的一些选项。

2.1.1. 使用原生方式安装 Rakudo Star

Rakudo Star 下载页面 http://rakudo.org/downloads/star/ 为 Windows 和 Mac OS 提供了二进制安装程序。你只需打开下载文件即可安装它们。

2.1.2. 二进制 Linux 包

Rakudo OS Packages[5] 仓库包含如何在 CentOS、Debian、Fedora 和 Ubuntu 系统上获取和使用 Raku 软件包的说明。它们带有编译器和一个用来安装 zef 的脚本; 对于我们的目的来说已经足够了。

2.1.3. 基于 Docker 的安装

在支持 Docker 的平台上, 你可以通过一条命令获得一个预构建的轻量级镜像, 其中包含 Raku 编译器以及 zef:

$ docker pull moritzlenz/raku-regex-alpine这个 Docker 镜像包含 Raku 以及一些模块, 这些模块可以让你更容易地使用正则表达式和 grammar。

一旦你拉取了这个镜像, 你就可以用它来执行单行程序, 具体方法如下:

$ docker run -it moritzlenz/raku-regex-alpine -e 'say "hi"'由于 Docker 容器在自己隔离的世界中运行, 所以你需要采取额外步骤来使容器中的脚本文件可用。例如, 如果你想执行一个脚本 search.p6, 你可以像这样运行它:

$ docker run -it -v $PWD:/raku -w /raku \

moritzlenz/raku-regex-alpine search.p6这很不方便, 所以用 bash 别名(或 shell 脚本)可以帮助你:

$ alias p6d="docker run -it -v $PWD:/raku -w /raku

moritzlenz/raku-regex-alpine"在这之后, 执行脚本就变得简单多了:

$ p6d search.p6一般情况下, 本书假定存在 raku 可执行文件。如果你使用 docker 镜像, 那么在所有命令中用 p6d 替换 raku。

2.2. 使用 Raku

你可以通过运行 raku --version 来验证你的 Raku 安装是否正常, 应该打印出类似这样的东西:

This is Rakudo version 2017.05-315-g160de7e built on MoarVM version 2017.05-25-g62bc54e

implementing Raku.c.一旦成功了, 你可以通过运行不带参数的 raku 启动一个简单的交互式 shell:

$ raku

To exit type 'exit' or '^D'

> say "Hello, world";

Hello, world

> exit在这个 shell 中, 你可以输入几行 Raku 代码, 这些代码会立即被执行。这对于测试正则表达式非常有用:

> say "Hello, world" ~~ / \w+ /

⌜Hello⌟(如果你还不明白这里到底发生了什么, 不要担心; 下一章会详细解释。)

然而如果提示符返回这样的东西:

$ raku

You may want to `zef install Readline` or `zef install

Linenoise` or use rlwrap for a line editor.

To exit type 'exit' or '^D'

>你应该按照问候信息中的建议, 安装它提到的一个模块。这样你就能访问和编辑你的命令的历史记录了:

$ zef install Linenoise

===> Searching for: Linenoise

===> Searching for missing dependencies: LibraryMake

...

===> Installing: Linenoise:ver('0.1.1'):auth('Rob Hoelz')当然, 你也可以使用 raku 来执行脚本文件, 只需在命令行中添加脚本文件即可:

$ raku greet.p6

Hello, world假设你在当前工作目录下有一个文件 greet.p6, 其中包含了 say "Hello, world";。

2.3. 获取代码示例

本书中使用的代码示例的源代码可以在 GitHub 上找到:

$ git clone https://github.com/apress/perl-6-regexes-and-grammars.git如果你没有 git, 你也可以从 https://github.com/apress/perl-6-regexes-and-grammars/archive/master.zip 下载一个包含源代码的压缩包。

我鼓励你运行这些示例脚本, 修改并运行它们。这是比单纯阅读本书更深入学习这些主题的最好方法。

2.4. 使用 Raku 的第一步

为了有效地使用 Raku 中是正则表达式, 你需要了解一下他们所嵌入的语言。

Raku 是一门自由形式的语言, 所以你可以随意缩进你的代码。然而, 有些情况下, 是否有空格是很重要的: doit(1, 2, 3) 调用带有 3 个参数的函数 doit, 而 doit (1, 2, 3) 只用单个参数来调用同一个函数, 这个参数是一个 3 个值的列表。

语句之间用分号(;)字符隔开, 你也可以在程序的最后一行放一个分号。注释以井号字符(#) 开头, 并一直延伸到行尾:

say "Hello, World"; # Output: Hello, World

say( 2 * 21 ); # Output: 422.4.1. 变量和值

变量是用关键字 my 来声明的, 并以 sigil 符号开头, 这告诉我们一些关于变量的一般类型:

my $x = 1;

my @capitals = 'Algiers', 'Tirana', 'Berlin', 'Tokio';

my %populations =

Algiers => 3_500_000,

Berlin => 3_700_000,

Tirana => 353_400,

;$ 代表标量变量 - 通常是持有单一值的变量。作比之下, @ 表示数组, 一个线性的值的集合, 可以通过一个从零开始的索引来访问元素。在上一个代码块的上下文中, @capitals[0] 返回 'Algiers'。

哈希(其他语言称之为字典或映射)将键(字符串)与值关联起来。你可以通过 {} 索引操作符来查找一个键的值, 并使用几个有用的方法:

say %populations{'Algiers'}; # Output: 3500000

say %populations.keys.sort; # Output: (Algiers Berlin Tirana)

say %populations.values.sum; # Output: 75534002.4.2. 字符串

由于正则表达式作用在字符串上, 我们就应该多说说它们。

字符串是由 Unicode 字符组成的序列。[7]我们已经看到了一些由单引号 '' 和双引号 "" 包围的字符串的示例。 主要区别在于, 双引号可以实现转义序列, 如 \n 是换行符(换行)和变量插值, 即用变量的值替换变量名:

my $name = 'Larry';

say "Hello, $name"; # Output: Hello, Larry

say 'Hello, $name'; # Output: Hello, $name然而, 即使在单引号内, 也可以用反斜线转义单引号来插入单引号。出于同样的原因, 在这样的字符串中必须使用双倍的反斜线:

say 'a quote: \' a backslash: \\';

# Output: a quote: ' a backslash: \Here-documents 提供了一种编写多行字符串的简洁方法:

my $macbeth = q:to/END/; # need to put the ; on this line!

When shall we three meet again?

In thunder, lightning, or in rain?

When the hurlyburly's done,

When the battle's lost and won.

END

# normal Raku code resumes here你可以选择自己的分隔符, 但习惯上将其全部大写, 以便更容易找到 here-document 的结束位置。

2.4.3. 控制结构

像循环和分支这样的控制结构都遵循相同的基本模式, KEYWORD EXPRESSION { BLOCK }, 而且 if 结构也允许附加 elsif 和 else 语句:

for 1, 2, 3 {

say $_;

}

if 1 > 2 {

say "No Way";

}

elsif 1 == 2 {

say "Still no chance";

}

else {

say "This runs";

}这个代码产生如下输出:

1

2

3

This runs在 for 循环块内, 当前值存储在特殊变量 $_ 中。如果你想使用不同的变量, 可以使用下面的语法, 这就是所谓的尖号块:

for 1, 2, 3 -> $value {

say $value;

}这在任何可以使用一个块的位置都可以使用, 也可以扩展到多个参数:

my $callback = -> $x, $y { $x + $y };

say $callback(1, 2); # Output: 32.4.4. 函数、类和方法

函数或子程序是一段带有形式参数列表以及可选的返回值的代码:

sub double($x) {

return 2 * $x;

}

say double(2); # Output: 4如果没有运行 return 语句, 那么返回值是最后一个表达式的值 , 所以我们可以把它写成 sub double($x) { 2 * $x }。

你可以选择为参数(和变量)声明一个类型:

sub double(Numeric $x) { 2 * $x }类可以有每个对象的存储, 称为属性, 而代码是附加到对象上的方法:

class Point {

has $.x;

has $.y;

method magnitude() {

return sqrt($.x * $.x + $.y * $.y);

}

}

my $p = Point.new( x => 5, y => 2 );

say $p.x; # Output: 5

say $p.magnitude(); # Output: 5.38516480713452.4.5. 了解更多关于Raku

有很多资源可以深入学习 Raku。

-

Moritz Lenz 的 Raku 基础: 从示例, 项目和案例入门。[8], 提供了一种示例驱动的方法来探索 Raku。

-

Andrew Shitov 的 Raku Deep Dive[9], 是一本更注重功能的类似主题的指南。

-

http://rakuintro.com/ 是一个免费的学习 Raku 的在线资源, 有多种语言版本。

最后但并非最不重要的是, Raku 的官方文档 https://docs.raku.org 提供了介绍性和参考资料, 可以让你搜索内置的类型、函数、方法和操作符。

2.5. 总结

我们已经看到了几种安装 Raku 编译器的方法。 安装完毕之后, 就可以通过运行不带参数的 raku 启动一个交互式的 Raku shell, 或者 raku script.p6 来执行 Raku 程序。

我们还探索了我们的第一个简单的 Raku 程序。接下来我们将直接开始编写我们的第一个正则表达式。

3. 正则表达式构造块

说了这么多, 准备了这么多, 是时候看一些实际的正则表达式了。

3.1. 字面量

正则表达式中最简单的元素是字面量: 即完全匹配自己的字符串。例如, 正则表达式 /perl/ 匹配任何包含 p,e,r 和 l 字符的字符串, 它们的顺序正好是这样的。因此, 字符串 "properly" 从第四个字符开始匹配此正则表达式(properly), 但字符串 "superficial" 不匹配, 因为它在 per 和 l 之间包含了其他字符(ficia)。

仅由字母, 下划线 _ 和数字组成的字面量不需要任何特殊的语法。只需将字母和数字写为正则表达式的一部分写成字面量即可。其他字面量必须用引号括起来, 要么使用单引号要么使用双引号: /'2016-12-24'/ 和 /"2016-12-24"/ 类似, 两者都与字符串 2016-12-24 匹配。由于这两个破折号既不是字母也不是数字, 所以需要成为引号字符串的一部分, 才能从字面上匹配。单引号和双引号对儿在插值方面的行为有所不同: 变量和花括号 {…} 分隔的代码块在双引号中被插值, 所以下面的正则表达式都匹配字符串 "3":

$_ = 3; # the string to be matched against

my $x = 3;

say "yes" if /"$x"/; # Output: yes

say "yes" if /"{1 + 2}"/; # Output: yes而正则表达式 /'{1 + 2}'/ 只匹配字面字符串 {1 + 2}。

在 Raku 正则表达式中, 默认情况下会忽略空格, 所以 /perl/, /pe rl/, 和 / p e r l/ 都是等价的(尽管后两个产生一个警告), 而且匹配的字符串完全相同。在引号里面, 空格是重要的, 所以 /"pe rl"/ 与字符串 properly 不匹配, 因为该字符串中没有空格字符, 但引号内的字符串有。

3.2. 元字符与字面量

正如我们在上一节中看到的那样, 正则表达式中的字母数字字符与它们自身匹配。所有其他字符都可能有一些特殊的含义。 我们已经看到 ' 和 " 是特殊的: 它们包围着被引用的字符串。

我们称这种"特殊"字符为元语法或元字符。 反斜线 \ 使字面量字符变得容易, 反之亦然。例如, /d/ 匹配字面的 d, 但 /\d/ 可以匹配单个数字。另一方面, 正则表达式中的 + 修饰前一个字符, 但是 /\+/ 匹配的是一个加号, 也就是 +。唯一的例外是 # 字符, 它不能通过反斜线前缀来匹配字面意思, 必须用引号代替。

并非所有元字符都有特殊的语义含义。例如, 感叹号(!)没有元语义, 并且 Raku 产生一个适当的错误信息:

$ raku -e '/!/'

===SORRY!=== Error while compiling -e

Unrecognized regex metacharacter ! (must be quoted to match literally)3.3. Anchors

正则表达式会搜索整个字符串以查找匹配项。有时这不是你想要的。锚点只在字符串中的某些位置进行匹配, 从而将正则表达式匹配锚定在该位置。

最常见的锚点是 ^ 和 $。它们分别匹配字符串的开头和结尾。正则表达式 /^go/ 匹配以字母 g 开头的字符串 , 例如 gown。相比之下, /go$/ 匹配所有以字母 o 结尾, 其前面由 g 开头的字符串, 例如 tango。 最后, 同时使用这两个锚点的正则表达式, /^go$/ 只匹配字符串 go。

由于空格通常被忽略, 我们可以将这些正则表达式写为 / ^ go /, / go $ / , 或 / ^ go $ /。

但是 / g ^ / 和 / $ g / 这两个正则表达式无法匹配任何字符串, 因为没有一个字符串在其开始之前或结束之后都有一个字符。一般来说, 如果你写出这样的正则表达, Raku 不会发出警告或抱怨, 尽管未来的版本可能会产生警告。如果你需要一个永远不可能匹配的正则表达式, 可以使用 <!>, 它可以达到同样的效果, 但更加明确。

字符串可以由多行组成; 锚点 ^^ 和 $$ 分别匹配行的开头和结尾。$$ 锚的特殊之处在于, 它匹配换行符之前, 如果没有尾随换行符, 则匹配字符串的末尾:

# Start-of-line positions that ^^ matches:

"⏏ab\n⏏de"

"⏏ab\n⏏de\n"

# End-of-line positions that $$ matches:

"ab⏏\nde⏏"

"ab⏏\nde⏏\n"锚点是零宽度的正则表达式元素。因此他们不会"消耗"输入字符串中的字符, 也就是说, 它们不会推进正则表达式引擎尝试匹配的当前位置。一个好的心理模型是, 它们在输入字符串的两个字符之间(或在输入字符串的第一个字符之前, 或在输入字符串的最后一个字符之后)进行匹配。

Raku 中内置了更多的锚(表 3-1)。

锚点 |

描述 |

样例 |

^ |

字符串开头 |

"⏏some\nlines" |

^^ |

行的结尾 |

"⏏some\n⏏lines" |

$ |

字符串结尾 |

"some\nlines⏏" |

$$ |

行的结尾 |

"some⏏\nlines⏏" |

<< |

左单词边界 |

"⏏some ⏏words" |

« |

左单词边界 |

"⏏some ⏏words" |

>> |

右单词边界 |

"some⏏ words⏏" |

» |

右单词边界 |

"some⏏ words⏏" |

<?wb> |

任意单词边界 |

"⏏some⏏ ⏏words⏏!!" |

<!wb> |

非单词边界 |

"s⏏o⏏m⏏e w⏏o⏏r⏏d⏏s!⏏!" |

<?ww> |

单词内 |

"s⏏o⏏m⏏e w⏏o⏏r⏏d⏏s!!" |

<!ww> |

非单词内 |

"⏏some⏏ ⏏words⏏!⏏!⏏" |

单词边界是字母数字字符组和下划线(_)以及任何其他字符之间的边界。例如, 字符串 "some-words_here" 就包含这些单词边界: "⏏some⏏-⏏words_here⏏"。注意, 在这种情况下 _ 字符的周围没有边界。它被当作一个字符来处理。

3.4. 预定义字符类

如果你必须拼写出每个要匹配的字符, 那么正则表达式就非常受限了。而字符类则放宽了这一要求。例如, 点(.) 代表任何一个字符。

你可以使用它来解决填字游戏, 效果非常好。假设你正搜索一个五个字母的单词, 你知道第二个字母是 e, 最后两个是 rl。这几乎可以是任何字符串, 对吧?

一旦有了单词列表, 你就可以用正则表达式 / ^ .e.rl $ / 来测试每个单词, 这样可以大大减少需要考虑的单词数量。

有些 Linux 发行版会自带一个文件 /usr/share/dict/words, 其中包含一个英文单词表, 每行一个单词。搜索这样一个单词列表只需一个非常短的脚本:

for '/usr/share/dict/words'.IO.lines -> $word {

say $word if lc($word) ~~ / ^ .e.rl $ /;

}在我的系统(Ubuntu 16.04)上, 这只产生两行输出:

Pearl

pearl它们只是在大小写上有区别, 所以对于填字游戏, 它们是一样的。

这个脚本是如何工作的? 代码 '/usr/share/dict/words'.IO 创建了一个 IO::Path 对象, 并在其上调用 .lines 方法返回文件中的一系列行。for 循环会在这些行上进行迭代, 这些行也正好是单词。

命令 say $word 打印单词, 然后跟着一个换行符, 但是只有满足 if 后缀的条件才打印。lc($word) 返回小写的 $word, 最后一行的其余部分检查小写单词是否与正则表达式 / ^ .e.rl $ / 匹配。

由于字符类非常有用, 所以 Raku 有很多字符类。有些字符类由反斜线和一个小写字母组成。在这些情况下, 大写版本是否定意义的(表 3-2)。

字符类 |

描述 |

匹配样例 |

不匹配样例 |

. |

任意字符 |

a, 4, |

|

\d |

数字 |

1, ٤ |

a, |

\D |

非数字 |

a, |

1, ٤ |

\w |

单词字符 |

a, 4, |

+, /, " " |

\W |

非单词字符 |

+, /, " " |

x, 4, ٤ |

\s |

空白符 |

" ", "\t" |

a, -, 4 |

\S |

非空白符 |

a, -, 4 |

" ", "\t" |

\n |

逻辑换行符 |

"\n", "\c[LINE SEPARATOR]" |

"\t", |

\N |

非换行符 |

"\t", +, a |

"\n" |

\h |

水平空白 |

" ", "\t" |

"\n", a, 4 |

\H |

非水平空白 |

"\n", a, 4 |

" ", "\t" |

所有这些分类都考虑了完整的 Unicode 字符序列; 所以 \d 不只是匹配 0 到 9 的数字, 还匹配所有脚标和变体的数字, 例如 ٤ - ARABIC-INDIC DIGIT FOUR。在支持 Unicode 9 版本的 Rakudo 2017.05 中, 有 580 个不同的字符与 \d 字符类匹配。

如果要找出所有匹配某个字符类的字符, 你可以迭代所有 Unicode 字符。下面是一个例子, 它列出了所有匹配 \n 的字符:

for 0..0x1FFFF -> $c {

if chr($c) ~~ /\n/ {

printf "U+%05X - %s\n", $c, $c.uniname

}这会产生如下输出:

U+0000A - <control-000A>

U+0000B - <control-000B>

U+0000C - <control-000C>

U+0000D - <control-000D>

U+00085 - <control-0085>

U+02028 - LINE SEPARATOR

U+02029 - PARAGRAPH SEPARATORchr($c)[10] 将代码点编号 $c 转换为它背后的实际字符。printf[11] 是一个例程, 用于打印根据模板格式化的输出, uniname[12] 返回 Unicode 字符数据库中字符的名称。

3.4.1. 用户自定义字符类

你也可以指定自己的字符类, 而不是只依赖于 Raku 正则表达式中的字符类。最简单的方法是在 <[ 和 ]> 之间枚举它们:

say 'perl' ~~ / <[aeiou]>/; # Output: ⌜e⌟在字符类中, 非字母数字字符会失去其特殊含义, 所以 / <[ " ']> / 匹配单引号或双引号。例外的是空格, 它们被简单地忽略, 和结束方括号 ] (它结束字符类, 所以必须使用反斜线转义才能成为字符类的一部分)以及反斜线。要匹配开口或闭合方括号, 请使用正则表达式 / <[ [ \] ]> /。

你可以在自定义字符类中包含预定义的字符类: / <[ \w $ - ]> / 匹配单个字符, 这个字符可以是一个单词字符(\w)、连字符或美元符号。

字符范围可以简化连续字符的列表。例如, / <[ 0..9 a..f A..F ]> 匹配十六进制字符, 换句话说, 它匹配这些字符中的任何一个: 0123456789abcdefABCDEF。

你可以通过在字符类前面添加一个减号( - )来否定字符类。因此, 要匹配除双引号之外的任何字符, 可以使用 / <-[ " ]> /。这是一个更通用语法的特例, 可以让你混合和匹配肯定和否定的字符类以及预定义的字符类:

/ <[\d]-[78]+[abc]> /此正则表达式可以匹配除 7 和 8 之外的任何数字, 但它也匹配字符 a, b 和 c。

最后, 单个字符的反斜杠转义符在字符类中的作用就像在双引号字符串中那样, 所以 <[ \c[ CHARACTER TABULATION] x ]> 和 <[ \t x ]> 都匹配字母 x 或制表符。

3.4.2. Unicode 属性

Raku 还通过引入 Unicode 属性和类别[13]提供对字符类的访问。要在正则表达式中使用 Letter 属性, 你可以写 <:Letter> 以匹配作为字母的单个字符, 或 <:!Letter> 作为它的否定 - 也就是说, 一个不是字母的单个字符。其中一些属性有简短形式, 如 <:L> 表示 <:Letter>。

这些属性不限于你目前正阅读的拉丁字母, 而是包括整个 Unicode 字符数据库。所以 <:Letter> 可能与希腊文, 西里尔文或希伯来文字母或来自任何具有字母概念的脚本的字母相匹配 (表 3-3)。

属性 |

短形式 |

例子 |

Letter |

L |

aΦЊ |

Uppercase_Letter |

Lu |

AЊ |

Lowercase_Letter |

Ll |

xή |

Mark |

M |

|

Number |

N |

83⁄4 |

Decimal_Number |

Nd |

8 |

Symbol |

S |

$÷϶ |

Math_Symbol |

Sm |

+±∄ |

Punctuation |

P |

!@_ |

3.5. 量词

到目前为止, 我们看到的正则表达式都匹配固定数量的字符。这种情况即将改变。量词控制其前面的正则表达式元素(原子)的匹配频次, 因此允许可选和重复的元素。

+ 量词匹配它前面的原子一次或多次。例如, / ^ a+ $ / 匹配字符串 a, aa, aaa, aaaa, 等等。

量词的绑定非常紧密, 比正则表达式元素的连接更紧密 , 因此 / ab+ / 匹配 ab, abb, abbb 等。你可以把它写成 / a [b+] / 以消除任何歧义。

如果你想匹配 ab, abab, ababab, 你可以使用引号或括号来强制 + 应用于多个字符: / [ab]+ / 和 / 'ab'+ / 都匹配这些字符串。前者比较通用, 因为它不仅适用于字面量, 也适用于其他的正则表达式。/ [\d+ ',']+ / 匹配一个数字列表, 每个数字后面跟一个逗号。

还有更多的量词, 如表 3-4 所示。

量词 |

最少匹配 |

最多匹配 |

? |

0 |

1 |

* |

0 |

infinite |

+ |

1 |

infinite |

**4 |

4 |

|

** 4..20 |

4 |

20 |

* 4.. |

4 |

infinite |

最一般的形式是 ** RANGE 量词, 其中 RANGE 可以是 MIN..MAX, 表示有上限的范围, 或者 MIN .. * 表示没有上限的重复:

/ ^ a ** 4 $ /; # Matches exactly 4 a's

/ ^ a ** 2..4 $ /; # Matches between 2 and 4 a's

/ ^ a ** 5..* $ /; # Matches at least 5 a's3.5.1. 贪婪和节俭量词

量词在默认情况下是贪婪的: 它们会尽可能多地匹配。

你可以通过对一个有多种可能匹配方式的字符串应用正则表达式来观察这种行为:

say "<a> b <c>" ~~ /"<" .+ ">"/; # Output: ⌜<a> b <c>⌟这里的正则表达式与整个字符串匹配, 从第一个 < 到最后一个 >。如果这不是你想要的, 你可以在量词上添加一个问号(?)来控制量词的贪婪性:

say "<a> b <c>" ~~ /"<" .+? ">"/; # Output: ⌜<a>⌟Raku 社区把这个版本的量词称为节俭量词, 尽管这个名字在一般的正则表达式文献中并不普遍。还有人称之为懒惰量词。

在一般量词的情况下, ? 出现在范围之前, 就像这样: **?1..5。

3.5.2. 带分隔符的量词

解析由固定分隔符连接的列表项是一项常的见任务。你可以使用 / <thing> [<separator> <thing>]* / 或者如果允许尾随的分隔符, 则使用 / <thing> [<separator> <thing>]* <separator>? /。 如果要允许空列表, 则需要进行更多修改。

Raku 提供了一个快捷方式: /<thing>+ % <separator>/, 可以匹配一个由 <separator> 分隔的 <thing> 列表。如果允许尾随分隔符, 只需将 % 更改为 %% 即可。这适用于任何量词。因此, <thing>* % <separator> 也可以匹配空字符串。

例如, 用逗号分隔的数字列表可以被解析为:

say '1,24,5' ~~ / [\d+]* % ',' /; # Output: ⌜1,24,5⌟当你把节俭量词与分隔符功能结合起来时, 请把节俭量词 ? 放在前面:

say '1,24,5' ~~ / [\d+]*? % ',' /; # Output: ⌜⌟3.6. 析取

"Hi," "Hello," 和 "Hey" 可能都是英语中被普遍接受的问候语。 匹配这种问候语的正则表达式必须接受这三个选项中的任何一个:

/ Hi | Hello | Hey /竖条 | 分割分词中的备选项或分支。在这个例子中, 这些分支不一定要像这个例子中的字面意思; 他们可以是任何一个正则表达式。

Raku 就是这样, 正则表达式分词有两种形式。单个垂直条形式与产生较长匹配的分支相匹配。如果两个或多个匹配的长度相同, 那么以字面量开始的分支就会获胜, 所以对于正则表达式 /a.|../ 匹配字符串 ab, 第一个备选项比第二个备选项更符合。

如果你将垂直条加倍, 则从左到右依次进行选择, 并且, 第一个匹配的备选项胜出:

say 'aab' ~~ / a+ | \w+ /; # Output: ⌜aab⌟

say 'aab' ~~ / a+ || \w+ /; # Output: ⌜aa⌟在前面的示例中, a+ 匹配 aa, 而 \w+ 可以匹配整个字符串 aab。在 | 的情况下, | 作为析取运算符, 更长的匹配胜出, 因此该正则表达式匹配整个字符串。对于 ||, 第一部分, a+ 匹配成功, 所以甚至不需要尝试第二个分支。

当你编写备选项时, 你可以让第一个分支留白, Raku 会忽略这个空的分支。这纯粹是出于审美的原因, 所以你可以这样写:

/

| first branch

| second branch

| third branch

/而不是在视觉上有点不太平衡的这种写法:

/

first branch

| second branch

| third branch

/3.7. 连接

你可以把 | 和 || 看作逻辑或。但是 AND 运算符呢? 大多数的正则表达式实现都会省略它, 但 Raku 却没有。它被拼写成了 &, 就像分词一样, 有一个顺序变体 &&。当我们在后面的章节中讨论你正则表达式的副作用时, & 和 && 之间的区别就会很明显。

当你有一个正则表达式并想要进一步地约束它时, & 运算符很有用。举例来说, 你可能正在文本文档中搜索电话号码, 而你已经有一个电话号码的正则表达式了, 但你记得你要查找的号码中, 有一个 17 的序列。你可以使用此正则表达式搜索这样的号码:

/ <phonenumber> & .* 17 .* /& 连词的分支必须匹配字符串的同一部分 , 所以这里 17 用 .* 拉伸右分支的匹配到左分支的匹配来填充。

你可以使用同样的技巧来排除某些字符的匹配。例如, 一个不包含数字 9 的电话号码可写为:

/ <phonenumber> & <-[9]>* /3.8. 零宽断言

你怎么能实现自己的锚点呢?

到目前为止, 我们讨论过的正则表达式结构不允许你这样做, 因为他们都需要消耗字符来决定是否匹配。

零宽度断言将另一个正则表达式变为锚点, 使它们不消耗输入字符串中的任何字符。它们有两种变体: 向前查看和向后查看断言。[14]

向前查看断言被拼写为 <?before regex>, 它将正则表达式转换为锚点。因此, 如果你想匹配数字后跟一个单位 (例如 KB 表示千字节或 MB 表示兆字节), 但不匹配单位本身, 你可以用这样的正则表达式来匹配:

say 'up to 200 MB' ~~ / \d+ <?before \s* <[kMGT]>? B > /;

# Output: ⌜200⌟在这里, 正则表达式 \s* <[kMGT]>? B 匹配可选的空格, 然后是单位 B、KB、MB、GB 或 TB。周围的 <?before …> 使只有当单位的正则表达式匹配时, 匹配才会成功。请注意, 这个断言没有推进字符串中正则表达式的位置, 因此匹配单元的字符串不包含在整个正则表达式所匹配的字符串中。[15]

你可以使用 ! 代替 ? 来否定向前查看。所以要匹配一个数字, 其后面不是单位, 你可以使用正则表达式:

say 'up to 200 MB' ~~ / \d+ <!before \s* <[kMGT]>? B > /;

# Output: ⌜20⌟在这种情况下, 正则表达式只匹配字符串 20, 因为它是一个后面不直接跟随单位的数字。如果你根本不想让它匹配这个输入字符串, 你可以在这个数字周围使用单词边界断言:

say 'up to 200 MB' ~~ / « \d+ » <!before \s* <[kMGT]>? B > /;

# Output: Nil我们也可以编写从当前位置向后查看的正则表达式, 而不是向前看字符串。匹配一个后面跟随逗号的数字, 你可以这样写:

say '200,50' ~~ / <?after \, > \d+ /; # Output: ⌜50⌟say '200,50' ~~ / <!after \, > \d+ /; # Output: ⌜200⌟使用正向和反向向前查看和向后查看断言, 你可以重新实现内置的锚点,[16] 你也可以编写自己的锚点。例如, ^ 匹配字符串的开头, 也可以写成 <!after .>; 只有在没有字符出现在它之前时才匹配。同样地, 左单词边界 «, 可以写成 <!after \w> <?before \w>。左单词边界就可以写成 <!after \d> <?before \d>。

需要注意的是, <!after \w> 和 <?after \W> 虽然相似, 但不尽相同。不同之处在于, <!after \w> 匹配字符串的开头, 而 <?after \W> 不是, 因为它需要匹配一个非单词字符。

3.9. 总结

正则表达式的基本构建块是字面值、字符类、锚点、量词、分词(备选项)和连词(重叠)。他们构成了使用 Raku 正则表达式进行检索、验证和解析的基础。

4. 正则表达式和 Raku 代码

现在你已经知道了正则表达式的基本构件, 我们将探讨在 Raku 代码中使用正则表达式的不同方法。

4.1. 智能匹配

智能匹配操作符 ~~ 是一个通用的比较运算符, 它右侧的对象决定了比较的语义。 例如, 如果右侧的对象是数字, 则 ~~ 就会进行数值比较。如果右侧的对象是一个类型, 则检查左侧的对象是否为该类型(或其子类型)。

我们特别感兴趣的是, 右侧是正则表达式的情况。 在这种情况下, 智能匹配操作符将左侧解释为字符串, 并使用该正则表达式搜索匹配:

my $str = "If I had a hammer, I'd hammer in the morning";

say $str ~~ /h.mm\w*/; # Output: ⌜hammer⌟

say $str ~~ /hummer/; # Output: Nil如果匹配失败, 则匹配的返回值为 Nil, 或者如果匹配成功则返回一个匹配对象。[17]如果在布尔值上下文中使用匹配对象 (比如 if 语句的条件), 则它的计算结果为 True (而 Nil 计算为 False); 在字符串上下文中(或通过调用 .Str 方法将其强制转换为字符串上下文时), 它计算为与正则表达式匹配到的字符串部分。从 say 输出的角括号( ⌜ 和 ⌟ ) 表示匹配对象。

my $str = "If I had a hammer, I'd hammer in the morning";

say $str.match(/h.mm\w*/); # Output: ⌜hammer⌟4.2. 引号形式

到目前为止, 我们已经看到由两个斜杠 /…/ 分隔的正则表达式, 但是还有其他的方法来编写正则表达式。这些都是等价的:

/ a.b /;

rx/ a.b /;

rx{ a.b };

rx! a.b !;

regex { a.b }如果你使用 rx 编写正则表达式, 则可以使用几乎所有的非单词字符作为分隔符(除了空格、冒号(:)和井号(#)之外)。

前面介绍的形式返回一个 regex 类型的对象, 你可以将其存储在变量中, 或者在智能匹配操作中使用。

此外, 还有一个使用 m(意为 match)而不是 rx 的形式。 它不是返回正则表达式对象, 而是立即将正则表达式与特殊变量 $_ 匹配:

$_ = 'abc';

if m/b./ {

say "match";

}由于智能匹配运算符 ~~ 自动将 $_ 设置为表达式的左侧, 所以在智能匹配中可以使用 m/…/:

say "abc" ~~ m/b/; # Output: ⌜b⌟4.3. 修饰符

修饰符改变了正则表达式的工作方式。它们分为两类。如果你把正则表达式看作是被编译为字节码[19]的小程序, 那么有些修饰符会影响编译, 有些修饰符则会影响你调用程序的方式。

例如, :global 修饰符(短形式 :g)属于后一类; 它指示正则表达式搜索字符串中所有不重叠的匹配:

my $str = "If I had a hammer, I'd hammer in the morning";

say $str.match(:global, /h.mm\w*/).join('|');

# Output: hammer|hammer第一种类别的一个例子是 :ignorecase(简称 :i), 它指示正则表达式引擎忽略大小写, 因此正则表达式中的大写字符可以与小写的等效字符匹配, 反之亦然[20]:

say 'Hello, world'.match(/:i hello/); # Output: ⌜Hello⌟如前文所示, 影响到正则表达式编译的修饰符可以在正则表达式本身内部使用。影响编译后的正则表达式行为的修饰符总是在外部使用。

由于 m/…/ 形式是立即匹配的, 所以你也可以给它添加会影响正则表达式的运行时行为的修饰符:

say ('abc' ~~ m:g/./).elems; # Output: 3这里 m:g/./ 返回一个含有三个匹配项的列表, 所以 .elems 方法返回数字 3。(见表 4-1。)

长形式 |

短形式 |

描述 |

:ignorecase |

:i |

匹配时忽略字母大小写 |

:ignoremark |

:m |

匹配时忽略重音或组合字符 |

:sigspace |

:s |

把空白视为重要的 |

:ratchet |

:r |

禁用回溯 |

:ignoremark 或 :m 修饰符允许你只用基本字符进行匹配, 而忽略变音符号和其他装饰字符的标记。在 :m 的作用下, /a/ 可以匹配 a, à, á, â, ã, ä, å, ā 和其他 22 个字符。

:sigspace 修饰符使 grammar 匹配中的空格与字符串中的空格匹配, 尽管不一定是一对一的映射。:ratchet 修饰符禁用回溯, 所以如果正则表达式引擎成功地以一种方式匹配字符串, 它不会再尝试以另一种不同的方式匹配。我们稍后将更详细地讨论这两个修饰符。

这些修饰符也可以放在正则表达式的中间, 或者通过方括号组 […] 组来限制正则表达式的一部分:

/ ab :i cd /; # match only the cd case-insensitively

/ [:i ab] cd /; # match only the ab case-insensitively你还可以通过在冒号后面添加感叹号来禁用修饰符。所以最后一个正则表达式可以写成 /:i ab :!i cd/。 (见表4-2。)

长形式 |

短形式 |

描述 |

:global |

:g |

找到所有不重叠的匹配 |

:overlap |

:ov |

|

:exhaustive |

:ex |

找到所有可能的匹配 |

:continue(5) |

:c(5) |

从位置 5 开始搜索 |

:pos(5) |

:p(5) |

从位置 5 开始并锚定 |

:nth(5) |

返回第 5 个匹配 |

如果你用 :global 搜索多个匹配项, 则第二个匹配的搜索从第一个匹配结束的地方开始。使用 :overlap, 第二个匹配的搜索从第一个匹配的下一个字符开始, 因此这两个匹配的匹配字符串可以重叠。:exhaustive 修饰符找到所有可能的匹配, 即使有几个匹配都从同一个位置开始。

如果你使用不带参数的 :continue 和 :pos 修饰符, 它们将默认为上一个匹配离开时的位置。

4.4. comb 和 split

my @numbers = "1308 5th Avenue".comb(/\d+/);

say @numbers; # Output: [1308 5]my ($city, $area, $popul) = 'Berlin;891.8;3671000'.split(/';'/);

say $area; # Output: 891.8在这里, 正则表达式只包含一个字面量; 在这种情况下, 你可以直接将字面字符串传递给 split, 就像 'Berlin; 891.8; 3671000'.split(';'); 那样。

comb 和 split 方法都接收第二个可选的参数 limit:

my ($city, $rest) = 'Berlin;891.8;3671000'.split(';', 2);

say $city; # Output: Berlin

say $rest; # Output: 891.8;3671000split 方法对于解析简单文件格式很有用, 例如逗号分隔的不带引号的文件。

4.5. 替换

你不仅可以用正则表达式来匹配文本, 还可以用正则表达式来转换文本。

say '42 eur'.subst( rx:i/ « eur » /, '€'); # Output: 42 €如果替代者是空字符串, 则替换将删除匹配的字符串:

say '42 €'.subst(/\s+/, ''); # Output: 42€与正则表达式匹配一样, 修饰符和替换可以一块儿用。例如, :global 替换正则表达式匹配的所有出现过的字符串(而不仅仅是第一个, 即没有修饰符时):

say '1 2 3'.subst(/\s+/, ''); # Output: 12 3

say '1 2 3'.subst(:g, /\s+/, ''); # Output: 123如果你希望替换的字符串取决于匹配到的值, 你可以传递子程序或块作为替换部分, 它接收匹配对象作为其参数:

say "9 of spades".subst(/\d+/, -> $m { $m + 1 });

# Output: 10 of spades在这种替换块中, 像 $0, $1 等匹配变量(下一章会有更多介绍)都不起作用, 除非你明确声明匹配变量 $/ 作为这个块的参数:

say "9 of spades".subst(/(\d+)/, -> $/ { $0 + 1 });

# Output: 10 of spades还有一种语法上的变体, 用于原地修改变量的替换。

my $var = '1 2 3';

$var ~~ s:g/ \s+ //;

say $var; # Output: 123注意, 在这种情况下, 第一个斜线和第二个斜线(/)之间的部分是一个正则表达式, 但第二个斜线和第三个斜线之间的部分是一个字符串。这意味着在第一部分中, 空格被忽略, 但在第二部分中空格是有关的。在替换字符串内部, 你可以使用 $0、$1、$2 等等, 用于引用捕获(有关捕获的更多信息, 请参阅下一章):

my $var = '"fantastic", she said';

$var ~~ s:g/ \" (.*?) \" /«$0»/;

say $var; # Output: «fantastic», she said如果你使用 […] 或 {…} 来分隔正则表达式, 那么替换部分也可以是 Raku 表达式:

my $ad = 'Buy now! USD 10 per book. Prices double soon to 20.';

$ad ~~ s:g[ \d+ ] = 2 * $/;

say $ad;其中 $/ 指的是匹配对象。注意, 在这种情况下, 赋值运算符是在右侧之前使用的。

这会产生如下输出:

Buy now! USD 20 per book. Prices double soon to 40.当你替换零宽度匹配时, 替换就变成了插入操作:

my $input = "It's just a jump to the left.

And then a step to the right.";

$input ~~ s:g/ <?before jump> /⇑/;

$input ~~ s:g/ <?before left> /←/;

$input ~~ s:g/ <?after right> /→/;

say $input;这里的 <?before …> 和 <?after …> 将它们内部的正则表达式变成零宽度的正则表达式, 所以替换命令并不会替换匹配的文本(如 "jump"), 而是在匹配之前或之后插入替换部分

:

It's just a ⇑jump to the ←left.

And then a step to the right→.你可以把普通匹配和零宽度匹配结合起来。例如, 这个语句将后面跟着单位 MB 或 GB 的所有数字都替换为 500:

my $input = '2 links with 75MB each';

say $input.subst(:g, / \d+ <?before <[MG]> B>/, 500);

# Output: 2 links with 500MB each4.6. 跨越代码和正则表达式边界

正则表达式和普通的 Raku 代码编译成相同的字节码, 而你可以将 Raku 代码和正则表达式混合使用。

最明显的交互方式是将 regex 对象存储在变量, 然后在普通代码中使用它们:

my $word-regex = /\w+/;

say "Hello, world" ~~ $word-regex; # Output: ⌜Hello⌟这样, 你可以为正则表达式起个名字, 同时也可以做所有其他可以用变量做的事情: 把它们放到数据结构中, 然后从函数中返回, 等等。

反过来也可以。变量可以成为正则表达式的一部分:

my $audience = 'world';

my $greeting = 'Hello';

if "Hello, world" ~~ / $greeting ', ' $audience / {

# this branch is executed

}如果一个变量包含一个字符串, 它总是按字面意思匹配; 如果它包含正则表达式, 则作为正则表达式匹配。

如果要把变量的内容解释为正则表达式, 你必须将它包含在尖括号中:

my $audience = "\\w+";

my $greeting = 'Hello';

if "Hello, world" ~~ / $greeting ', ' <$audience> / {

# this branch is executed

}此示例还演示了反斜杠必须在引用的字符串中加倍 - 本例中是赋值给变量 $audience - 但不是正则表达式。在双引号字符串中, 反斜杠引入了一个转义序列(例如 \n 表示换行符, \t 表示制表符)。使用语法 <$audience> 可以将变量 $audience 的内容解释为正则表达式。

在正则表达式中使用数组变量相当于将数组中的每个元素作为备选项进行匹配; 因此

my @numbers = 'one', 'two', 'three';

my $regex = / @numbers /;等价于这样写:

my $regex = / [ 'one' | 'two' | 'three' ] /除了一点, 使用数组变量时, 用程序化的方式提供值比较容易。

最后, 你可以在正则表达式中包含 Raku 代码块, 只需将其嵌入到花括号中即可。这对于在执行正则表达式时建立数据结构(如符号表)很有用 。

例如, 我们可以计算字符串中数字出现的次数:

my $count = 0;

my $str = "between 23 and 42 numbers";

if $str ~~ / [ \d+ { $count++ } \D* ]+ / {

say $count; # Output: 2

}这里块 { $count++ }, 它将变量 $count 增量 1, 在正则表达式的 \d+ 部分之后执行。虽然这是一个有点构造化的用例, 我们将在后面的章节中看到正则表达式代码块的实际应用。

正则表达式中代码块的另一个很好的用例是添加 print 语句用于调试, 以查看正则表达式是如何匹配的。

这里我们尝试将浮点数与正则表达式匹配:

say '1.0e42' ~~ / ^ \d+ ['.' \d+]? [e|E \d+]? $ /;这个正则表达式匹配失败了, 要看这个正则表达式匹配到什么程度, 你可以删除使片段可选的问号, 然后添加一些代码块来显示增量进度:

'1.0e42' ~~ / ^

\d+ { say "integer: '$/'" }

['.' \d+] { say "decimal place: '$/'" }

[e|E \d+] { say "exponent: '$/'" }

$ /;这产生如下输出:

integer: '1'

decimal place: '1.0'

exponent: '1.0e'我们可以看到这个正则表达式的最后一部分只匹配了 e, 而不是 e42。 仔细观察就会发现 [e|E \d+] 中的备选项延伸到了 \d+, 而这并不是本意。添加一个分组级别, [ [e|E] \d+ ], 修复该正则表达式。

这些代码块使用了特殊变量 $/, 它包含了匹配(或者至少是部分匹配, 就其进展而言)。

这些代码块的执行纯粹是为了它们的副作用。你可以使用 <?{…}> 形式来影响正则表达式匹配。如果该代码块中的代码返回 false 值, 则匹配失败[25]:

my $one-byte = / ^ \d ** 0..3 $ <?{ $/.Int <= 255 }> /;

for 0, 100, 255, 256, 1000 -> $num {

if $num ~~ $one-byte {

say $num;

}

}此示例的正则表达式匹配 0 到 255 之间的数字(例如, 可能用于验证 IPv4 地址), 并且只打印 0、100 和 255 这些数字。

$/.Int 调用将匹配的字符串转换为整数, 并且当且仅当该数字最多为 255 时比较 ⇐ 255 才返回 True。

语法 |

描述 |

{ CODE } |

运行 Raku 代码, 对正则表达式匹配没有影响 |

<?{ CODE }> |

匹配要成功, 则代码需要返回 true 值 |

<!{ CODE }> |

匹配要成功, 则代码需要返回 false 值 |

<{ CODE }> |

代码的结果被解释为正则表达式 |

<$STRING> |

将 $STRING 解释为正则表达式源代码 |

4.7. 总结

在本章中, 我们已经看到了如何在 Raku 代码中使用正则表达式, 反之亦然。你可以将正则表达式存储在变量中, 也可以在正则表达式中使用变量。

在下一章中, 我们将探讨如何从正则表达式匹配中提取信息或其中的部分信息。

5. 从正则表达式匹配中提取数据

当你使用正则表达式来验证输入时, 只要知道给定的字符串是否匹配正则表达式就可以了。在其他很多情况下, 我们想要从字符串和正则表达式匹配中提取更多的数据。

比如说, 如果你想解析一个 INI 文件(Microsoft Windows 上常见的配置文件格式), 你可能会对节标题和节内的键/值对感兴趣; 但是, 节标题周围的方括号这样的东西我们就不感兴趣了。

5.1. 位置捕获

你可以通过指示一个正则表达式来捕获一些数据, 通过在正则表达式的一部分的周围加上一对圆括号来提取相关数据。然后, 这部分正则表达式匹配的字符串就会被单独提供:

if "Hello, world" ~~ / (\w+) ', ' (\w+) / {

say "Greeting: $0"; # Output: Greeting: Hello

say "Audience: $1"; # Output: Audience: world

}捕获从左到右, 从零开始编号。 第一对括号中的正则表达式匹配的字符串可以保存在特殊变量 $0 中, 第二对括号中的正则表达式匹配的字符串可保存在特殊变量 $1 中, 以此类推。

由于这些捕获的编号取决于它们在正则表达式中的相对位置, 我们称它们为位置捕获。

5.2. 匹配对象

匹配对象提供了大量关于正则表达式匹配的信息: $/.orig 包含了正则表达式匹配的字符串, $/.from 和 $/.to 包含了匹配的开始和结束位置, 在字符串上下文中使用它(或通过在它身上显式调用 .Str 方法)返回匹配的字符串。

但还有更多: 当你像使用数组一样使用匹配对象时, 你可以从捕获中访问匹配项。$0 实际上是 $/[0] 的别名 , $1 实际上是 $/[1] 的别名, 等等。

捕获本身也是 Match 对象:

my $input = "There are 9 million bicycles in Beijing";

if $input ~~ /(\d+) \s+ (\w+)/ {

say $0.^name; # Output: Match

say $1; # Output: ⌜million⌟

say $1.from; # Output: 12

say $1.to; # Output: 19

}5.2.1. 捕获嵌套

如果在其他捕获中嵌套捕获, 则匹配对象的结构对应于捕获的嵌套:

'abcdef' ~~ /(.) (b(c)(d(e))) /;

say $0.Str; # Output: a

say $1.Str; # Output: bcde

say $1[0].Str; # Output: c

say $1[1].Str; # Output: de

say $1[1][0].Str; # Output: e匹配对象实际上是一个匹配对象的树。

正如你在前面的示例中所看到的那样, 捕获的编号是按每一层嵌套的方式进行的; 在这个正则表达式中, 有五对圆括号, 但其中只有两对是顶层的, 所以匹配成功后只有 $0 和 $1, 没有 $2 或更高的级别。相反, 每一级的嵌套还引入了从 0 开始的匹配编号。这与 Perl 5 和 PCRE 语义不同, 在 Perl 5 和 PCRE 语义中, 匹配是连续编号的。

5.3. 命名捕获

当你有超过两个或三个以上的捕获时, 你可能会忘记哪个编号指向哪个捕获组。为了减轻这种负担, 并使代码在重构时更加健壮, 你可以使用命名捕获来代替:

my $str = 'Hello, World';

if $str ~~ / $<greeting>=[\w+] ', ' $<audience>=[\w+] / {

say $<greeting>.Str; # Output: Hello

say $<audience>.Str; # Output: World

}$<thename> 在正则表达式内部和外部都指向命名捕获。在正则表达式内部, 你可以给它分配一个名字, 然后在正则表达式外面你可以访问相应的匹配对象。在正则表达式外部, $<thename> 实际上是对匹配对象的命名访问的快捷方式, $/<thename> 或 $/{'thename'}。这种访问命名捕获的模式与访问哈希元素的语法相同。

如果在同一个正则表达式中使用了两次(或更频繁地)相同的名字, 那么捕获再次成为一个数组。

在后面的章节中, 我们将更详细地讨论命名正则表达式。对于现在, 创建命名捕获的更简单方法就是按名称调用正则表达式就足够了:

my regex byte {

\d ** 1..3

<?{ $/.Int <= 255 }>

}

my $str = '127.0.0.1';

if $str ~~ / ^ <byte> ** 4 % '.' $ / {

for $<byte>.list -> $byte {

say $byte.Str;

}

}这里 <byte> 调用命名正则表达式 byte, 并自动捕获由此同名子规则 byte 所匹配到的字符串。你可以使用语法 <alias=originalname> 来重命名捕获:

my $str = 'Hello, World';

my regex word { \w+ };

if $str ~~ /<greeting=word> ', ' <audience=word>/ {

say $<greeting>.Str; # Output: Hello

say $<audience>.Str; # Output: World

}5.4. 反向引用

反向引用允许你访问正则表达式内部的捕获, 匹配正则表达式的前一部分捕获的字符串。这里有几个可能有用的案例, 比如在文本中搜索意外重复的单词时。第一次尝试将是这样的正则表达式: / (\w+) \s+ $0 / 这个正则表达式匹配一个单词(\w+)并将其捕获到 $0 中, 后面是空格(\s+), 然后再跟着原始单词($0)。然而这不符合预期。用它来匹配字符串 the next thing, 它会匹配 t t, 因为 \w+ 很乐意只匹配一个字符。

为了使它工作, 我们可以通过包括单词字边界断言: / « (\w+) \s+ $0 » / (记住 « 匹配左单词边界而 » 匹配右单词边界)来限制匹配整个单词。

现在, 如果你把它与字符串 "the quick brown fox jumps over the the lazy black dog" 进行测试, 它就会正确地匹配两个 "the"。

反向引用也适用于命名捕获; 前面的例子可以写成 /« $<word>=\w+ \s+ $<word> »/。

反向引用的另一个常见用例是查找类似于引号的字符串, 只要两端都是一样的, 你不用关心实际的引用字符。

请注意, 反向引用绝对超出了常规计算机科学中定义的语言的范畴; 你需要更强大的形式主义来实现。

5.4.1. 跑个题: 带反向引用的原始性测试

本节与任何实际应用无关, 但会让你深入了解人们用正则表达式所做的那些疯狂的事情。如果你只是出于实用的原因, 你可以放心地跳过这一部分。

质数是一个整数, 只能被数字 1 和它本身整除。

你可以使用正则表达式来检验一个数字是否为质数。[29]首先, 我们必须通过创建一个由相同字符组成的字符串(例如 a)来编码这个数字, 其中字符串中的字符数与数字相同。因此 2 将被编码为 aa, 5 将被编码为 aaaaa, 以此类推。在 Raku 中, 我们可以使用字符串重复运算符 x 来执行此操作:

my $encoded = 'a' x 5;然后, 我们尝试找到一个大于 1 的因子, 使这个数字均匀地被分割。在我们的编码字符串中, 这是一个由至少有两个字符组成的子串, 当重复次数足够多时(但至少一次)时, 就能重新实现原始编码字符串:

for 2..15 -> $number {

my $encoded = 'a' x $number;

if $encoded ~~ / ^ (a ** 2..*) $0+ $ / {

say "$number is not a prime, a factor is ", $0.chars;

} else {

say "$number is a prime";

}

}这产生如下输出:

2 is a prime

3 is a prime

4 is not a prime, a factor is 2

5 is a prime

6 is not a prime, a factor is 3

7 is a prime

8 is not a prime, a factor is 4

9 is not a prime, a factor is 3

10 is not a prime, a factor is 5

11 is a prime

12 is not a prime, a factor is 6

13 is a prime

14 is not a prime, a factor is 7

15 is not a prime, a factor is 5例如, 如果 $number 为 6, $encoded 就会变成 "aaaaaa"。当第一组(a * 2..)与三个 a(aaa)匹配时, 正则表达式引擎就会找到匹配。相应地, $0+ 产生另外三个 a, 总共六个 a。 在质数的情况下, 正则表达式引擎无法找到这样的分区, 导致匹配失败。

由于 ** 量词是贪婪的, 因此正则表达式引擎首先找到最大的质数因子, 因此它将 5 识别为 10 的质数因子。如果你把它改成 **? 量词(因此正则表达式变为 / ^ (a *? 2..) $0+ $ /), 它找到最小的质因数。

注意, 这是一种非常低效的测试质数的方法, 因为正则表达式引擎没有针对这种任务进行优化, 使用了一个非常低效的数字表示法, 甚至必须尝试所有可能的因子, 甚至是那些很容易被更智能的算法排除的因子。

尽管如此, 正则表达式引擎还是能在几秒钟内测试出多达五万个数字。Raku 有一种内置的方法来测试质数, 速度更快, 占用内存更少:

say 50101.is-prime; # Output: True5.5. 重温匹配对象

如前所述, 成功的正则表达式匹配会返回匹配对象。除了匹配的子字符串的位置和长度之外, 匹配对象还存储了所有位置捕获和命名捕获。要获取所有的位置捕获的列表, 可以调用 .list`方法。同样的, `.hash 方法也会将命名捕获作为一个散列返回。散列是一种数据结构, 具有从名称或键到值的映射; Python 称它为 dict 或字典, JavaScript 称之为对象。

当使用 say 函数打印匹配对象时, 输出的是以 ⌜⌟ 分割的匹配字符串:

say "abc" ~~ /../; # Output: ⌜ab⌟如果正则表达式包含了捕获, 则会在单独的行中打印出来, 并缩进一个空格。因此

say "abc" ~~ /.(.)(.)/产生输出:

⌜abc⌟

0 => ⌜b⌟

1 => ⌜c⌟其中 0 和 1 是捕获的索引。嵌套捕获会产生更多的缩进, 所以 "abc" ∼∼ /.(.(.))/ 打印出:

⌜abc⌟

0 => ⌜bc⌟

0 => ⌜c⌟因此, 命名捕获仅以其名称来区分:

"abc" ∼∼ /.(.$<char>=[.])/打印:

⌜abc⌟

0 => ⌜bc⌟

char => ⌜c⌟5.6. 总结

捕获允许你从成功的正则表达式匹配中提取数据。你可以通过在正则表达式的一部分的周围添加一对圆括号, 使用 $<name>=[…] 语法, 或者通过调用一个命名的正则表达式, 来指示正则表达式引擎捕获数据: <name>。

正则表达式匹配和捕获都产生匹配对象; 最上面的匹配对象会变成一棵子匹配树。反向引用允许你精确地匹配一个正则表达式的前一部分的匹配对象, 你可以滥用该功能来构建一个简单的质数测试。

6. 正则表达式技术性细节

正则表达式有时候会显得很神奇。它们往往有不同的方式来匹配字符串。匹配项是如何被找到的?哪一个匹配项先被找到?

本章通过解释正则表达式引擎的使用机制来揭开它神秘的面纱。理解这些机制是编写健壮的正则表达式的关键, 它可以满足你的需求, 不多也不少。

我们的讨论因 Raku 正则表达式中实现的两种不同范式而略显复杂: 带有限状态机的声明式匹配和更强大的回溯引擎。

6.1. 带状态机的匹配

当计算机科学家谈论正则语言时, 他们还描述了一种有效识别特定字符串是否属于正则语言的机制。在 Raku 中, 如果字符串与正则表达式匹配, 那么这只是简单地表示。

6.1.1. 确定性状态机

用于识别匹配字符串的机制是有限状态机。它是一组带有箭头的状态集。每个箭头都用单个字符标记。机器从输入字符串中单独读取每个字符, 并使用与标签相同的箭头作为当前的字符。如果没有标有当前字符的箭头, 匹配立即失败。

有些状态被标记为接受状态。在输入字符串中的最后一个字符被读取后, 如果最终状态为接受状态, 则匹配成功。否则就会失败(图 6-1)。

考虑一下这个例子中的自动机。起始状态是 A0, 从那开始, 它需要读取字符 a 来进入接受状态 A1。然后, 它可以读取一个 b, 然后再读一个 c, 回到接受状态, 所以它接受的字符串与正则表达式 / ^ a [bc]* $ / 相同。[30]我们称这它为自动机 A。

对于每个状态, 最多只有一个箭头携带某个特定字符离开该状态。因此, 该机器一次只处于一种状态, 而我们称其为确定性有限自动机, 简称 DFA。

DFA 可以在代码中非常有效地实现 。对于每个状态, 你只需要一个查找表, 将输入的字符映射到下一个状态, 这意味着你只需要在输入字符串的每个字符上花费固定的步数。

如前面的自动机所演示的那样, 你可以使用它匹配字面量, 你可以用反向的箭头来实现 * 量词。它还支持备选分支, 尽管它们可能比较麻烦。

首先, 让我们修改原来的自动机, 以匹配 / ^ a [bca]* $ / (图 6-2)。

我们称这个自动机为 B。

现在, 我们要构建一个自动机来匹配 A 或 B 匹配的字符串。我们可以通过创建一个同时运行两个自动机的自动机来实现。这两个自动机的起始状态是 A0 和 B0, 所以我们把新的起始状态叫做 A0B0。从这个起始状态开始, 读取一个 a 就会使自动机 A 从 A0 移动到 A1, 使自动机 B 从 B0 移动到 B1, 所以下一个状态是 A1B1。由于原始状态中至少有一个是接受状态, 所以 A1B1 也是接受状态(图 6-3)。

第三种状态也是非常明显的: 从 A1 或 B1 中读取 a b, 我们就可以分别移动至 A2 和 B2(图 6-4)。

现在开始变得有趣了: 在读取字符 c 时, A 转换为状态A1, 但 B 转换为状态 B0。对此我们需要一个状态, 我们称之为 A1B0。因为 A1 是接受状态, 所以 A1B0 也是接受状态(图 6-5)。

如果下一个字符是 a, 会发生什么? 自动机 A 拒绝了输入, 自动机 B 移动到 B1 状态。因此, 我们可以在这儿复制自动机 B(图 6-6)。

同样, 从状态 A1B0 中读取字符 b 使自动机 B 失败, 并将自动机 A 移动到状态 A2 中。因此, 我们可以将状态 A1 和 A2 复制到新的自动机中(A0 从那里是无法到达的), 我们得到了最终的结果(图 6-7)。

在我们的例子中, 生成的自动机有九个状态, 而 A 和 B 各只有三个状态。如果我们必须建立几个自动机的析取, 在最坏的情况下, 所得到的自动机的状态数与每个输入自动机的状态数的乘积成正比。或者换句话说, 状态的数量可以随着我们要建模的正则表达式的字符数成指数增长。

6.1.2. 非确定性状态机

这种状态爆炸限制了 DFA 在正则表达式匹配代码中的实用性。相反, 正则表达式实现通常使用非确定性有限自动机, 简称 NFA。NFA 允许用同一个字符标记多个箭头, 以区分不同的状态。NFA 的非确定性部分是, 正则表达式引擎必须猜测要跟随哪个箭头, 或者它只是跟随所有的箭头, 这就导致了机器可以同时处于一个以上的状态。

如果你把状态和标记的箭头视为一个游戏板, 开始匹配就会把一个芯片置于初始状态。当你读取一个输入字符时, 你按照所有相关的箭头, 在每个目标状态上放置一个芯片。最后, 你把之前的状态中的筹码去掉。

为了使 NFA 更容易构造, 人们通常允许所谓的 epsilon(ε)过渡。NFA 遵循这些箭头而不消耗一个输入字符。或者换个说法: 如果从状态 C0 到 C1 有一个 ε 过渡, 只要在 C0 上放置一个芯片放, 就会在 C1 上放置第二个芯片。

通过这些ε过渡, 创建两个自动机的分离变得简单了。你只需添加一个新的起点 C0, 然后从它开始添加 ε 过渡到你所组合的自动机的起点(图 6-8)。瞧, 就这样:

确定性和非确定性有限自动机是同样强大。对于每一个 NFA, 可以构造一个完全相同的字符串匹配的DFA。 反过来, 每一个 DFA 也是一个 NFA, 因为 NFA 的规则比 DFA 更宽松。

从正则表达式构建 NFA 通常比构建相应的 DFA 要快得多(而且可以使用更少的内存)。在运行时, NFA 可能需要推进多个状态(想想前面比喻中的芯片), 所以在最坏的情况下, 它需要采取的步骤数与每个输入字符的 NFA 状态数成比例。

Raku 使用 NFA 来匹配我们到目前为止讨论过的大部分正则表达式特性, 包括字素、量词、连词和分词以及字符类(只是分词的方便语法)。 NFA 不能处理检索符特征是顺序性的分词(||)和连词(&&), 锚点、反向引用、代码块和代码断言, 以及我们稍后讨论的一些特性: 带有显式回溯控制的正则表达式、递归、向前查看和向后查看。

6.2. 正则表达式控制流

在正则表达式引擎无法使用 NFA 的情况下, 或者理解 NFA 并不能提供很多关于正则表达式如何匹配的见解, 那么理解一般正则表达式的控制流程是有用的。

第一条规则是正则表达式引擎总是从字符串的开头开始, 并优先选择最左边的匹配。

第二条规则是贪婪规则: 正则表达式是从左到右进行计算的, 每一个匹配到可变字符数的部分都会尝试匹配它能匹配到的最长子串。[32]

因此, 如果你有一个正则表达式 / \w+ .* / 并将其与字符串 abcd 匹配, 那么 \w+ 会匹配整个字符串, 使 .* 成功匹配空字符串。\w+ 只匹配第一个字符, 剩余的 .* 同样允许匹配, 但不会发生, 因为这违反了正则表达式最左边的部分尽量匹配的规则。

如果你试图用一个简单的正则表达式 / \" .* \"/ 来匹配一个带引号的字符串, 那么它可能比你预期的要匹配的多:

my $str = 'Amanda sighed. "It was madness", she said. '

~ '"Sheer madness"';

if $str ~~ / \" .* \" / {

say $/.Str;

}这产生如下输出:

"It was madness", she said. "Sheer madness"因为 * 并不在意你不没有打算在第一个引号的边界之外匹配; 它只是尽可能多地匹配, 同时使使整个匹配成功。

6.3. 回溯

贪婪规则并不总是在第一次尝试时就会产生匹配。 在前面的例子中, .* 首先匹配了所有能匹配的东西, 包括输入字符串中的最后一个引号。但是在正则表达式中的最后一个引号没有匹配到, 导致了失败。

正则表达式引擎没有放弃, 而是开始回溯: 它回到了之前的量词(. 中的 ), 并使其少重复一次匹配。只有这样, 正则表达式中的引号才能找到输入字符串中的引号, 使整个正则表达式匹配成功。

如果有多个正则表达式元素可以以不同的方式匹配, 那么回溯会尝试从最后一个元素开始尝试所有的选项, 如果它们全部都失败了, 那么回溯就会从倒数第二个元素尝试另外一个选项。然后探索该配置中最后一个元素的所有变体, 并继续尝试从之前的元素中搜索匹配。如果你把它看成是搜索树, 那就是深度优先搜索。

让我们考虑一个带有两个可变部分的正则表达式, 结合搜索, 让我们一块儿看看:

'mabracadabra' ~~ / (.+a) (.*) $0 /;这开始时, 第一组 (.+ a) 匹配完整的字符串; 第二组 (.) 匹配空的字符串; 最后一部分, $0 匹配失败。因此, 回溯开始了, 它要求第二组匹配更少的字符, 但它不能; 所以它又回到了第一组, 要求它匹配更少的字符。现在, 第一组匹配了 mabracada, . 匹配了剩下的三个字符。但是, 最后一组仍然没有匹配成功, 所以 .* 放弃了另一个字符, 最后一组继续失败。如此循环, 直到第一组只匹配了两个字符, ma。 即使在这种配置下, 其余的正则表达式也无法成功匹配。正则表达式引擎没有选项了, 所以它采用了最后的机制: 它尝试在第二个字符的左边一个位置开始匹配。

从第二个字符开始, 第一个组再次尝试匹配整个剩余的字符串, abracadabra。我们可以通过添加在正则表达式的第二部分后面添加一个代码块来直观的说明:

'mabracadabra' ~~ /(.+a) (.*) { say "0: '$0'; 1: '$1'" } $0 /;0: 'mabracadabra'; 1: ''

0: 'mabracada'; 1: 'bra'

0: 'mabracada'; 1: 'br'

0: 'mabracada'; 1: 'b'

0: 'mabracada'; 1: ''

0: 'mabraca'; 1: 'dabra'

0: 'mabraca'; 1: 'dabr'

0: 'mabraca'; 1: 'dab'

0: 'mabraca'; 1: 'da'

0: 'mabraca'; 1: 'd'

0: 'mabraca'; 1: ''

0: 'mabra'; 1: 'cadabra'

0: 'mabra'; 1: 'cadabr'

0: 'mabra'; 1: 'cadab'

0: 'mabra'; 1: 'cada'

0: 'mabra'; 1: 'cad'

0: 'mabra'; 1: 'ca'

0: 'mabra'; 1: 'c'

0: 'mabra'; 1: ''

0: 'ma'; 1: 'bracadabra'

0: 'ma'; 1: 'bracadabr'

0: 'ma'; 1: 'bracadab'

0: 'ma'; 1: 'bracada'

0: 'ma'; 1: 'bracad'

0: 'ma'; 1: 'braca'

0: 'ma'; 1: 'brac'

0: 'ma'; 1: 'bra'

0: 'ma'; 1: 'br'

0: 'ma'; 1: 'b'

0: 'ma'; 1: ''

0: 'abracadabra'; 1: ''

0: 'abracada'; 1: 'bra'

0: 'abracada'; 1: 'br'

0: 'abracada'; 1: 'b'

0: 'abracada'; 1: ''

0: 'abraca'; 1: 'dabra'

0: 'abraca'; 1: 'dabr'

0: 'abraca'; 1: 'dab'

0: 'abraca'; 1: 'da'

0: 'abraca'; 1: 'd'

0: 'abraca'; 1: ''

0: 'abra'; 1: 'cadabra'

0: 'abra'; 1: 'cadabr'

0: 'abra'; 1: 'cadab'

0: 'abra'; 1: 'cada'

0: 'abra'; 1: 'cad'在尝试了 46 种不同的配置后, 它找到了一个匹配项: 从第二个字符开始, (.+ a) 匹配 abra, (.*) 匹配 cad, $0 再次匹配 abra。

从它们匹配的内容来看, 你可以清楚地看到, 正则表达式后面的部分比前面的部分变化更快。该正则表达式的起始位置的推进速度更慢, 事实上是最缓慢的变化。

正则表达式引擎永远不会回溯到零宽度断言(向前查看和向后查看的断言)。对于这些, 只看它们是否匹配, 而不看它们是如何匹配的, 因为成功的匹配从来不会消耗输入字符串中的任何字符(它匹配空字符串)。

6.4. 为什么要避免回溯

回溯是使正则表达式起作用的秘密魔力。它可以让计算机代表你努力工作, 并在输入字符串中找到匹配项。

但, 在某些情况下, 回溯会代码更大的伤害; 因此, Raku(以及其他一些正则表达式实现)提供了禁用回溯的方法, 或者减少回溯的工作量。

6.4.1. 性能

一个原因是性能: 回溯可能是计算密集型的, 如果你已经知道某个匹配(或匹配的一部分)会失败, 告诉计算机少做一些工作就会加快速度。

一个简单的例子是这个正则表达式匹配:

"aaaaaa" ~~ /^ (a+) <[bcd]> /;你可以看到这个匹配失败了, 因为输入字符串中没有 b、c 或 d。然而, 正则表达式引擎还不够聪明, 不知道这一点, 它必须这样搜索才能达到最佳性能。相反, 它首先尝试匹配输入中的所有 a, 然后是再少匹配一个 a, 以此类推, 然后再宣告失败。同样的, 我们可以通过一个嵌入的代码块来跟踪它的进度。 比如说 "aaaaaa" ∼∼ /^(a+) { say $0 } b/ 产生这样的输出:

⌜aaaaaa⌟

⌜aaaaa⌟

⌜aaaa⌟

⌜aaa⌟

⌜aa⌟

⌜a⌟

Nil在某些方面比计算机更聪明, 我们可以告诉它永远不要放弃它匹配的任何东西, 来帮助它。比如 说 "aaaaaa" ∼∼ /^(a+:) { say $0 } b/ 产生更短的输出:

⌜aaaaaa⌟

Nil量词后面的冒号(:)告诉它不要回溯这个量词。它不仅适用于所有的量词, 也适用于分词。这个量词与回溯控制冒号一起称为占有式量词, 因为这个量词永远不会放弃它曾经的拥有的东西。

第二种禁用回溯的方法是使用 :ratchet(或 :r) 修饰符, 你也可以在组 […] 或捕获 (…) 中使用。 在这种情况下, 修饰符的效果从使用点延伸到组的闭合括号。

6.4.2. 正确性

回溯有时会导致意外的匹配结果。之所以会发生这种情况, 是因为正则表达式的一部分按你所希望的方式匹配, 然后后面的一部分未能匹配。然后第一部分开始回溯, 并以一种意想不到的方式匹配。

当你尝试匹配一对 HTML 标记时, 如字符串 <a href="…">some text</a>, 你可以使用像这样的正则表达式:

my $html-re = rx:ignorecase{

'<' $<tag>=[ <[a..z]>+ ] # opening tag

<-[ > ]>* # attributes within opening tag

'>'

( .* ) # content between opening and

# closing tags

'</' $<tag> '>'

};

say 'more text <a href="..:">link text</a> bla' ~~ $html-re;这似乎是可行的, 但错误地匹配不匹配的标签, 如 <abc> </a>。这里的正则表达式引擎首先尝试 $<tag> 为 abc, 但没有找到匹配, 然后回溯。在第二次迭代中, 它尝试了 ab, 失败了, 第三次迭代成功了 $<tag> 是 a。

有人可能会说, 这个正则表达式有缺陷, 它匹配了开头的 HTML 标签之后, 它应该有一个词的边界断言。但是, 尽管如此, 我们对正则表达式匹配的直觉往往与量词的贪婪性相吻合, 而不是与回溯可能产生的更细微的匹配相吻合。

在编写正则表达式或解析器时, 问问自己关于单个元素的问题: 如果这部分正则表达式找到了匹配, 然后稍后又失败了, 那么是否我想让它尝试不同的匹配? 想象一下, 你正在为一种编程语言编写一个解析器, 编写一个与标识符匹配的正则表达式。 这个匹配是否应该放弃一两个字符? 可能不会。在这种情况下, 最好加上一个冒号(:)来防止它回溯: / $<tag>=[ <[a..z]>+: ] /

6.5. 节俭量词和回溯

正如前面一章中提到的, 有节俭量词或惰性量词, 尝试尽可能少地匹配。这些量词总是会回溯, 即使是在启用了 ratchet 修饰符的情况下也是如此。

当一个贪婪的量词试图尽可能多地匹配时, 即使不回溯, 也会通过应用量化的正则表达式元素, 看看是否匹配。另一方面, 节俭量词总是从以最小的匹配数量开始, 只有回溯才能让它匹配更多的元素。因此, 如果不进行回溯, / a ?? / 或 / a *?/ 只匹配空字符串, / a +?/ 只匹配单个 a, 以此类推。

6.6. 最长 token 匹配

带 | 的离散项或替代项更喜欢与最长的字符串匹配的分支。我们称之为最长的令牌匹配。

这在解析时非常重要, 因为它与我们自己直觉上识别文本的方式是一致的。例如, Raku 的表达式 $var` 可以被解析为前缀运算符 ` (将后面的变量增量1), 后面是变量 $var。或者, 它可以解析为 +(+$var), 将前缀 + 运算符(将其参数转换为数字)应用到 $var, 然后再将相同的运算符应用到结果中。Raku 语法是基于 regexes, 它知道更喜欢第一个变体(单个 ` 运算子), 因为当试图解析前缀运算符时, 它产生的匹配时间最长。footnote:[这是另一种你不希望回溯的情况:一旦解析器识别了 ` 运算符, 你不希望它改变主意, 把这两个字符解释为不同的运算符。]

为了能够有效地匹配最长的替代变量, Raku 会确定一个 regex 的哪些部分构成了声明性前缀。然后构造一个 NFA 来匹配这个声明性前缀。一旦完成后, 一般的正则表达式引擎的其他部分就会启动并继续进行, 直到找到下一个声明式前缀。

声明性前缀被限制在NFA可以建模的元素中:字元、字符类、分词、连词、连接词和贪婪量化器。在命名的regex调用的情况下, 命名的regex的声明性前缀会被合并到调用的regex中, 除非它会导致递归。

我们可以通过插入一个代码块 {}(它不是声明性的)来限制替代的长度来说明这一点(图6-9)。

say "abc" ~~ /ab | a.* /; # Output: ⌜abc⌟

say "abc" ~~ /ab | a {} .* /; # Output: ⌜ab⌟这里是正则表达式ab | a。*, 第二个分支匹配整体 string, 比第一个分支匹配的长。

通过插入空块 {}, 最长的令牌匹配是 有效地限于正则表达式ab | 一个。现在第一个分支ab产生了 较长的匹配(因为第二个分支的声明部分 只匹配“a”), 正则表达式引擎承诺做出这个决定, 只匹配“ab”。仅当后来的正则表达式元素无法匹配时(和 启用了回溯)正则表达式引擎会重新考虑这个决定。

6.7. 总结

计算机科学为我们提供了有效匹配常规语言的工具通过有限自动机。即便如此, 常规语言只是其中的一部分正则表达式可以描述什么。其余的是使用回溯处理, 它最喜欢最左边的匹配, 而不是更长的匹配匹配较短的匹配。

7. 正则表达式技术

前面几章介绍了许多你可以用来构建你的正则表达式的构造, 并解释它们的工作原理。但是, 仅仅这些并不能告诉你如何构造你的正则表达式以获得最佳结果。本章将提供这样的指导。

7.1. 了解你的数据格式

这可能是显而易见的, 但还是经常被忽视。为了能够为某些数据格式编写正则表达式, 你需要知道它的规则。也就是说, 如果有规则的话。如果没有, 你可能需要足够多的输入数据来制定规则。并对数据进行测试。然后, 你需要知道验证的背景。

7.1.1. 明确的数据格式

我们先来谈谈定义数据格式的情况。即使你认为自己对数据格式相当了解, 也值得去阅读规范。通常情况下, 有一些很少使用的边缘情况可能是值得考虑的。

例如, 像 johndoe 这样的字符串(没有任何 @ 符号)是一个有效的电子邮件地址, 可以用于本地发送。如果你要写一个电子邮件地址的正则表达式来进行输入验证, 是否应该允许? 答案取决于具体情况。如果你正在开发一个纯粹在公司内部使用的应用程序, 那么允许它可能是有意义的。而在公共 Web 应用程序中, 就不那么合理了。

保持电子邮件地址, 你知道本地部分可以被引起来吗? 或者域部分可以是 IP 地址, 还可以有方括号? 是的, "somebody"@[93.184.216.34] 和 some+body@[IPv6:2001:db8::1] 都是有效的电子邮件地址。

有些数据格式有其格式规范。例如 JSON, 即 JavaScript Object Notation, 它的主页上有解析规则。[34] 在这种情况下, 重复作者为创建这些规则所做的工作, 并简单地将它们翻译为 Raku 语法, 往往是一种实用的选择。

7.1.2. 探索数据结构

如果你没有现成的规范, 那么你必须来遵守自己的规则。提出这些规则的最好方法, 就像科学方法一样: 首先你提出一个假设, 然后再进行测试。你反复迭代, 直到你对结果满意为止。

测试关于数据格式的假设可以采用几种形式。如果你知道有另一个程序处理相同的数据格式, 你可以修改现有的数据格式的文件, 然后用另一个程序加载它们们。如果这不是一个选项, 你应该尝试收集尽可能多的现实世界中的数据, 以相同的格式, 然后通过这个语料库来检验你的假设。

让我们假设你想写一个解析 INI 文件的正则表达式, 它是 Microsoft Windows 平台上常用的配置格式。

在它的基本形式, 它看起来像这样(例子取自维基百科 INI 文件页面[35]):

; last modified 1 April 2001 by John Doe

[owner]

name=John Doe

organization=Acme Widgets Inc.

[database]

; use IP address in case network name resolution

; is not working

server=192.0.2.62

port=143

file="payroll.dat"规则看起来很简单: 文件由一系列章节组成。每节以方括号中的章节名开头, 并包含由等号(=)分隔的键/值对。空行和以分号(;)开头的行将被忽略。

现在是时候提出更多问题了:

-

章节列表可以是空的吗(也就是说, 空文件是否是有效的 INI 文件)?

-

章节可以为空吗(不包含任何键/值对)?

-

是否允许在键/值对后面加上注释? 例如, 如果你写了

port=443;只有一个没有被防火墙阻止, 注释是否是值的一部分? -

哪里允许空格? [database] 或 port=443 是否有效?

-

章节名中允许的是什么? 例如空格或开口括号? 那行的分隔符呢?

-

键也是如此。键中是否允许使用破折号(

-)? -

值的规则是什么? 它们会否延伸到行的末尾吗? 他们是否停止在注释标记处? 如果下一行不是注释、键/值对或章节标记, 它们是否可以是多行的? 是否允许空值?

-

是否允许使用转义序列(例如制表符的转义序列

\t)? 如果允许, 在哪里? 仅仅在值中, 还是在键或章节标题中? -

是否支持引用, 如果是, 在哪里引用?

-

是否允许在章节名称、键和值中使用非 ASCII 字符?

这些是分析纯文本数据格式时的典型问题。当你研究这些问题的答案时, 你可以把它们变成你的正则表达式的测试用例。

没有固定规范的数据格式通常有几种变体, 并且实现方式也不一样, 他们所接受的内容也不一样。在这种情况下, 你必须决定你是仅针对一个变体, 还是针对一个共同的子集, 或者是所有变体的超集。

7.2. 考虑无效输入

当你编写正则表达式时, 不要只考虑那些正则表达式应该匹配的字符串。对他们不应该匹配的字符串要同等重视。一般来说, 正则表达式应该拒绝的字符串比正则表达式应该接受的字符串多, 这使得这些字符串既重要又难于思考。

你可以做的一件事是写否定测试; 也就是说, 用不应该匹配的输入进行测试。另一个是当你看到 .* 或 .+ 这样的项时, 要停下来, 多想一想。这些词太宽泛了, 以至于大多数时候都是错误的。大多数数据格式都不包含"然后, 无论如何"这样的子句。 例如, 如果你解析到行尾的注释, /'#' .*/ 是错的, 因为它可以通过断行来匹配; /'#' \N* \n? / 是比较好的正则表达式。如果你解析类似于 C 的注释, / * ... * /, 正则表达式 / '/*' .* '*/' 也匹配整个字符串 /* abc */ de */, 因为 .* 贪婪地匹配了字符串中间的结尾注释标记 */。

7.3. 使用锚点

如果你写的正则表达式是为了匹配整个字符串, 请记住锚定 ^ 和 $ 以确保它确实匹配整个字符串。如果不是的话, 请考虑一下正则表达式匹配的边界。如果你试图匹配一个单词, 后面不跟着一个点(.), 那么正则表达式 /\w+ <!before '.'> / 可以匹配一个部分单词:

say "supercalifragilisticexpialidocious."

~~ / \w+ <!before '.'> /;

# Output: ⌜supercalifragilisticexpialidociou⌟这里的 \w+ 实际上匹配的字符是比实际的单词少一个, 所以 <!before '.'> 可以成功匹配。

如果这样的行为不是你想要的, 你可以添加一个断言, 比如单词边界, / \w+ » <!before '.'> /。 因为 \w+ 暗示单词的一部分已经被匹配了, 所以你也可以写 / \w+ <!before \w> <!before '.'> /。

断言的内容是一个正则表达式, 所以在这里我们必须引用点(或转义为 <!before \.>), 否则这个点会展开它的特殊含义, 以匹配任何字符。

7.4. 匹配引用的字符串

许多数据格式包括带引号的字符串。他们的定义特征是, 在两个(或更多的)分隔字符 - 引号之间允许更多的(通常几乎所有的)字符。

我们已经在 Raku 中看到过引用的字符串, 在 Raku 的正则表达式本身中, 可能会出现一些非单词字符, 而这些字符在正则表达式中是保留的。 常见的数据交换格式, 如 CSV、JSON 和 YAML 也包含引号。CSV-逗号分隔的值格式 - 有一个分隔符(默认为逗号(,); 因此而得名), 在类似于表格的结构中分隔列。如果列值本身包含逗号, 你必须能够将逗号与分隔符区分开来, 这通常是通过引号来实现的。

一个 CSV 文件, 包含列 a, 然后是 b, c, 最后是 d 列(即三列), 可以写成:

a,"b,c",d其中 "b, c" 是带引号的字符串。

如前所述, / \" .* \" / 不是解析引号字符串的有效方法 , 因为 .* 可以匹配断开的结尾引号。如果输入的内容是:

a,"b,c",d,"e,f"那么被引用的字符串的正则表达式实际上会与输入中的两个被引用的字符串以及中间的列匹配。

一个不那么幼稚的方法是写成 / \" .*? \" /, 这样可以将引用的字符串限制在最短的匹配范围内。这个方法是可行的, 但前提是没有任何东西迫使正则表达式以不同的方式回溯和匹配:

say '"a,b","' ~~ / ^ \" .*? \" $ /; # Output: ⌜"a,b","⌟这里的输入是一个不平衡的引号字符串, 中间有第三个引号字符。第一次尝试只匹配了字符串中的 "a, b" 部分, $anchor 没有匹配, 因此回溯开始, 下一次尝试匹配整个字符串。

这通常不是理想的行为。一种更稳健的方法是放弃正则表达式中的点, 并更努力地思考引号字符串中允许的内容: 这很容易用否定的字符类来实现:

say '"a,b","' ~~ / \" <-["]>* \" /; # Output: ⌜"a,b"⌟

say '"a,b","' ~~ / ^ \" <-["]>* \" $ /; # Output: Nil现在这只匹配一个平衡的引号字符串。

7.4.1. 引用带有转义序列的字符串

我们的挑战并未就此结束。在前面的 CSV 示例中, 我们现在可以处理包含分隔字符的列, 但由于引号字符获得了特殊的含义, 你不能轻易拥有包含引号字符的列。

解决这个问题最常见的方法是引入一个转义字符, 通常是反斜线(\)。如果你在引号字符或反斜线之前加上一个反斜线, 那么第二个字符就失去了其它的特殊意义。 因此, 如果你想在 CSV 列中包含 she said "hey, ho" 这个字符串, 你必须把它写成 "she said \"hey, ho\""。

使用反斜杠作为转义字符的工作变得更加复杂, 因为反斜线在 Raku(以及大多数其他编程语言)中也有特殊的含义。所以, 在普通的字符串文字中, 你必须将反斜线加倍, 才能产生一个反斜线:

say "a\\b"; # Output: a\b你可以在 Raku 中关闭这种行为, 在字符串前面加上一个大写的 Q, 这样就可以关闭所有的转义序列:

say Q"a\b"; # Output: a\b say Q"a\\b"; # Output: a\\b正则表达式没有这种模式, 所以你必须在正则表达式中使用双倍的反斜线来匹配字面的反斜线。

说到带转义字符的引号, 现在有两种情况需要考虑在引号字符串中使用: 无意义的常规字符和转义序列。常规字符是指除了引号或反斜线以外的所有字符, 字符类 <-["\\]> 描述了这一点。转义序列是一个反斜杠, 后面是引号或反斜线。用正则表达式的术语来说, 那就是 \\ <["\\]>。许多数据格式也允许在反斜线后面加上其他字符, 在这种情况下, 序列简化为 \\。(记住, 点可以匹配任何字符)。

将这两种情况结合在一起, 就可以得到这样的字符序列:

my regex quoted {

\" # opening quote

[

<-[ " \\ ]> # regular character

| \\ . # escape sequence

]*

\" # closing quote

}如果你花了一分钟或更长的时间来阅读这本正则表达式, 不要担心。这是个需要拆解和理解的地方, 但这将是本书中涉及最多的正则表达式。 my regex quoted {…} 构造声明一个命名正则表达式作为词法变量。稍后, 我们将学习 grammar, 在 garmmar 中我们可以省略 my。

7.5. 测试正则表达式

正则表达式是一种代码。它们是声明性, 而不是程序性的, 这意味着在编写正则表达式时, 你要指定它匹配的是什么文本, 而通常不是如何匹配。但是, 它们仍然是代码, 你应该为代码编写测试, 以获得对他们按预期工作的信心, 并且能够改变他们而不用担心破坏其他使用它们的代码。

Raku 自带了一个测试模块, 可以很容易地编写这样的测试。 下面是上一节中的正则表达式的小测试套件:

my regex quoted {

\" # opening quote

[

<-[ " \\ ]> # regular character

| \\ . # escape sequence

]*

\" # closing quote

}

my @should-match =

Q<"abc">,

Q<"abc\\">,

Q<"ac\\def\"ef">,

;

my @should-not-match =

Q<abc>,

Q<"abc"def">,

Q<"ab\\"cdef">,

;

use Test;

plan 6;

for @should-match -> $s {

ok $s ~~ / ^ <quoted> $ /,

"Successful match of string $s";

}

for @should-not-match -> $s {

nok $s ~~ / ^ <quoted> $ /,

"Successful rejection of string $s";

}让我们来详细探讨一下。一开始是我们熟悉的正则表达式声明。然后代码声明并初始化两个数组变量, @should-match 和 @should-not-match。

第一个包含了我们希望正则表达式匹配的字符串; 第二个变量包含了正则表达式不应该匹配的字符串的例子。

接下来是两个 for 循环, 用于检查示例字符串。ok 是一个测试函数, 当使用真值作为其第一个参数时, 它可以使测试成功; 而假值则使测试失败。这里的第一个参数是锚定的正则表达式匹配的结果, $s ~~ / ^<quoted>$ /。第二个参数是测试的标签。在第二个循环中, 使用了测试函数 nok 来代替, 它的逻辑和 ok 相反: 它期望第一个参数是假值(如正则表达式匹配失败)。

当你运行这个脚本时, 它会产生这样的输出:

$ raku quotes-with-escapes.p6

1..6

ok 1 - Successful match of string "abc"

ok 2 - Successful match of string "abc\\"

ok 3 - Successful match of string "ac\\def\"ef"

ok 4 - Successful rejection of string abc

ok 5 - Successful rejection of string "abc"def"

ok 6 - Successful rejection of string "ab\\"cdef"如果你改变了前三个示例字符串中的一个使正则表达式匹配失败, 你就会得到一个像这样的失败测试输出:

$ raku quotes-with-escapes.p6

1..6

ok 1 - Successful match of string "abc"

not ok 2 - Successful match of string "abc\\"a

# Failed test 'Successful match of string "abc\\"a'

# at quotes-with-escapes.p6 line 26

ok 3 - Successful match of string "ac\\def\"ef"

ok 4 - Successful rejection of string abc

ok 5 - Successful rejection of string "abc"def"

ok 6 - Successful rejection of string "ab\\"cdef"

# Looks like you failed 1 test of 6对于文件中的许多测试, 甚至是许多测试文件, 有一个所有测试输出的总结是很有帮助的。通常与 Perl 5 捆绑在一起的 prove 程序可以理解测试的输出(以测试任何协议格式[37])并打印出一个简短的摘要:

$ prove -e raku quotes-with-escapes.p6

quotes-with-escapes.p6 .. ok

All tests successful.

Files=1, Tests=6, 1 wallclock secs ( 0.02 usr 0.00 sys + 0.24

cusr 0.01 csys = 0.27 CPU)

Result: PASS如果测试失败, 它将重点放在失败的测试上, 这样更容易修复:

$ prove -e raku quotes-with-escapes.p6

quotes-with-escapes.p6 .. 1/6

# Failed test 'Successful match of string "abc\\"a'

# at quotes-with-escapes.p6 line 26

# Looks like you failed 1 test of 6

quotes-with-escapes.p6 .. Dubious, test returned 1 (wstat 256,0x100) Failed 1/6 subtests

Test Summary Report

-------------------

quotes-with-escapes.p6 (Wstat: 256 Tests: 6 Failed: 1)

Failed test: 2

Non-zero exit status: 1

Files=1, Tests=6, 0 wallclock secs ( 0.01 usr 0.01 sys 0.23 cusr 0.01 csys = 0.26 CPU)

Result: FAILprove 甚至在终端输出中增加了颜色, 绿色表示"所有测试成功", 红色表示"测试失败", 让状态一目了然。

在最初开发完你的正则表达式之后, 你很可能想用它们来做一些测试以外的事情。在这种情况下, 你可以将测试提取到一个子程序中, 只有当你用一个特殊命令行参数调用你的脚本时才会运行它们, 比如 --test:

my regex quoted {

\" # opening quote

[

<-[ " \\ ]> # regular character

| \\ . # escape sequence

]*

\" # closing quote

}

multi sub MAIN(Bool :$test!) {

my @should-match =

Q<"abc">,

Q<"abc\\">,

Q<"ac\\def\"ef">,

;

my @should-not-match =

Q<abc>,

Q<"abc"def">,

Q<"ab\\"cdef">,

;

use Test;

plan 6;

for @should-match -> $s {

ok $s ~~ / ^ <quoted> $ /,

"Successful match of string $s";

}

for @should-not-match -> $s {

nok $s ~~ / ^ <quoted> $ /,

"Successful rejection of string $s";

}

}

multi sub MAIN($input) {

if $input ~~ / ^ <quoted> $ / {

say "$input is a quoted string";

}

else {

say "invalid input: $input";

exit 1;

}

}在这个例子中, multi sub MAIN 引入了一个名为 MAIN 的子例程。Raku 会自动为你调用子程序 MAIN, 并将命令行参数转换为这个函数的参数。multi 意味着可以有一个以上的子例程。Raku 会调用参数中最适合的候选参数。:$test! 是一个命名参数, 因为前面的冒号(:)和后面的感叹号(!)使它成为必需的。

只有通过命名参数测试, 才能调用这个候选参数。这是它在命令行中的样子:

$ raku quote-checker --test

1..6

ok 1 - Successful match of string "abc"

ok 2 - Successful match of string "abc\\"

ok 3 - Successful match of string "ac\\def\"ef"

ok 4 - Successful rejection of string abc

ok 5 - Successful rejection of string "abc"def"

ok 6 - Successful rejection of string "ab\\"cdef"或者,如果你想使用 prove 测试套件。

$ prove -e "" "raku quote-checker.p6 --test"

raku examples/quote-checker.p6 --test .. ok

All tests successful.

Files=1, Tests=6, 0 wallclock secs ( 0.01 usr 0.00 sys 0.26 cusr 0.02 csys = 0.29 CPU)

Result: PASS

----第二个候选程序, 用 multi MAIN($input) 声明, 是程序的"正常"执行路径。它需要一个位置参数, 在命令行中是一个不是选项的字符串(所以不以减号(-)字符开头)。它检查参数是否是一个引号字符串, 并打印出相应的信息:

$ raku quote-checker '"yes"'

"yes" is a quoted string

$ raku quote-checker no

invalid input: noshell 使用了一层引号, 这就是为什么在第一次调用时, 我在双引号字符串周围使用了单引号。这在标准的 POSIX shell 和 bash 中都可以使用; 其他的 shell 可能需要你使用不同的引号来运行这个例子。

7.6. 总结

当我们在为一个数据格式编写正则表达式时, 经常会发现我们对这个数据格式的了解比我们原先想象的要少。我们可以尝试找到一个正式规范来回答我们问题, 或者我们可以使用实验的方法, 结合我们对数据格式的问题目录, 来进行实验。

我们还讨论了在哪些正则表达式应该匹配的边界上使用断言, 以及巧妙地使用否定字符类来可靠地解析引用的字符串, 即使是在有转义字符的情况下也是如此。

测试可以让我们确信, 我们编写的正则表达式的匹配度不会超过也不会低于我们的期望, 我们探索了一种简单的方法来编写自动测试。

8. 重用和组合正则表达式

Raku 提供了很好的工具来组合正则表达式, 从而使其可重用。这激励着程序员像对待普通代码一样, 精心地组织和测试他们的正则表达式。

8.1. 命名正则表达式

给正则起名字, 并能够通过名称来引用这些正则, 是实现可组合性和重用正则表达式的第一步。

正如我们之前在一些例子中看到的那样, 你可以给正则表达式起名字, 就像你给变量、子程序等起名字一样。这就把正则表达式提升到了和语言中其他构造一样的高度, 使抽象化成为可能。

my regex byte {

\d ** 1..3

<?{ $/.Int <= 255 }>

}

my $str = '127.0.0.1';

say $str ~~ / ^ <byte> ** 4 % '.' $ /;这里的 my regex byte { … } 声明了一个名为 byte 的正则表达式。regex 前面的关键字决定了作用域: my 是词法作用域的。 如果省略 my 关键字, 则声明一个附加到 grammar 上的正则表达式。稍后会有更多介绍。

Raku 中的正则表达式是代码对象, 就像子例程或方法一样。就像例程一样, 你可以通过在正则表达式的名字前加上一个 & 符号来引用正则表达式[38]:

say &byte.^name; # Output: Regex

say &byte ~~ Code; # Output: True与一般的子例程不同, 你不能直接调用正则表达式; 它需要一个游标对象用于跟踪其进度。这就是你尝试之后得到的结果:

$ raku -e 'my regex a { . }; a("x")'

No such method '!cursor_start' for invocant of type 'Str'相反, 你可以使用智能匹配来调用正则表达式, 就像使用匿名正则表达式那样:

my regex a { . };

say "x" ~~ &a; # Output: ⌜x⌟当然也可以从一个匿名的正则表达式内部调用它:

my regex a { . }; "x" ~~ / <a> /;通过尖括号语法 <a> 来调用一个命名正则表达式, 会创建一个和被调用的正则表达式同名的命名捕获, 这里是 a。如果你想避免捕获, 你可以将其写为 <&a>。

如果你想让捕获的名字不同, 则可以将其写为 <b=&a>。 这会生成一个命名捕获 b, 但会调用名为 a 的正则表达式。如果你写的是 <b=a>, 那么同一个捕获在名字 a 和名字 b 下都可用。还有更多方法可以调用命名正则表达式(表 8-1)。

例子 |

描述 |

捕获 |

<a> |

命名正则表达式调用 |

a |

<&a> |

非捕获命名正则表达式调用 |

(none) |

<b=a> |

带别名的命名正则表达式调用 |

a,b |

<b=&a> |

重命名的命名正则表达式调用 |

b |

<?a> |

命名正则表达式调用作为向前查看 |

(none) |

<!a> |

命名正则表达式调用作为否定向前查看 |

(none) |

如果开口 < 后的第一个字符是一个单词字符, 那么就会产生一个与该单词同名的命名捕获。任何形式的标点符号 - 不管是用于向前查看的 ? 还是用于普通调用的 &, 都会抑制捕获。

8.1.1. 词法分析与回溯控制

在传统的解析文献中, 分析一段文本通常会经历两个阶段: 词法分析, 也称为标记化, 然后是实际的解析。

词法分析将一段文本分解为 token, 即带有分类标签的小块文本。例如, 如果我们要写一个小计算器, 输入 2 * (3 + 5) 就会产生一个像这样的 token 流:

2 number

* product

( opening parenthesis

3 number

+ addition

5 number

) closing parenthesis这些 token 最初是一个线性列表; 然后解析步骤将它们转换为一个树, 我们可以用来对表达式进行求值:

*

/\

2 +

/\

3 5这种两步法对于简单的东西, 比如基本的数学表达式, 效果很好, 但是当解析具有上下文相关的子语言时, 往往会失败。如果你要为 Raku 编写一个解析器, 主语言的词法分析与引用的字符串内部的词法分析是非常不同的, 这与正则表达式内部的词法分析有很大的区别。

为了适应这种情况, Raku 提供了关键字 token, 它引入了一个关闭回溯的正则表达式。我们的想法是, 词法分析应该足够简单, 一旦你决定了如何切割并标记一个 token, 你就不希望根据后来的输入来放弃这个决定。因此, 不需要回溯。

通过在普通的正则表达式匹配中进行词法分析, 我们就有了决定应用何种标记化所需的所有上下文。

本章的第一个例子涉及一个正则表达式 byte, 这个例子足够简单, 我们通常不需要回溯。因此, 我们可以重写它来代替使用 token:

my token byte {

\d ** 1..3

<?{ $/.Int <= 255 }>

}

my $str = '127.0.0.1';

say $str ~~ / ^ <byte> ** 4 % '.' $ /;my token byte { … } 的作用与在正则表达式 my regex byte { :r …} 中明确地禁用回溯是一样的。然而, 它的使用频率很高, 以至于它应该有自己的语法。

请注意, 我们有时使用 regex 这个词来指代使用 token 关键字声明的正则表达式。

8.2. 空白

回到标记化一个简单的数学表达式的例子, 我们忽略了一个重要的细节:输入中包含了 token 之间的空白, 而 token 流之间不包含空白。词法分析通常会丢弃无关紧要的空白。

并非所有的空白都是无关紧要的。 你不希望写出 "Hello, World", 并让它变成 Hello, World。 许多语言对空白做了区分, 即 token 之间的空白在 token 之间是无关紧要的, 但 token 内的空白(如引号字符串)是重要的。

然而, 它比这更微妙:在 SQL, Perl, Python, JavaScript 等语言中, 当一个类似于单词的 token 后跟着一个非单词的 token 时, 你可以省略空白, 或者反过来(例如 a+b 和 a + b 是相同的)。 然而, 禁止将两个类似于单词的 token 连接在一起而不留任何空白。 相反, 如果两个 token 之间存在空白, 那么空白的数量就无所谓了。[39]

例如, 下面这两个 SQL 语句生成相同的解析树:

SELECT username,first_login FROM account;

SELECT

username,

first_login

FROM account;相反, 下面是一个语法错误, 因为它连接了类似于单词的 token 而不带任何空格:

SELECTusername,first_loginFROMaccount;Raku 定义了一个名为 ws 的正则表达式, 它是 whitespace 的缩写, 它按照前面的规则解析空白:任意数量的空白(空格、制表符、换行符, ……), 但至少有一个空白, 除非它位于单词边界。或者用代码表示, regex ws { <!ww> \s* }(其中 <!ww> 匹配除了单词内之外的任何地方)[40]。

还有一个快捷方式可以帮助你避免在代码中到处使用显式的 <ws> 或 <.ws> 调用。[41] 如果使用关键字 rule 而不是 regex 或 token 来声明正则表达式, 那么 Raku 会在你的正则表达式中使用空格的地方插入隐式的 <.ws> 调用。这与在正则表达式中使用 :sigspace 或 :s 修饰符具有相同的效果。

由于 ws 的定义使用了术语 \s*, 所以正则表达式中的单个空白可以匹配字符串中的任何数量的空白, 包括制表符、空格、垂直制表符等。

再次考虑我们的数学表达式, 我们可以编写以下正则表达式来匹配两个数字之和的最简单情况:

my token number { \d+ }

my rule sum { <number> '+' <number> }

say '1+2' ~~ / ^ <sum> $ /;

say '1 + 2' ~~ / ^ <sum> $ /;第二行相当于写为:

token sum { <number> <.ws> '+' <.ws> <number> <.ws> },但可读性更强。最后两行都匹配成功了, 唯一的区别是它们匹配的空白:

⌜1+2⌟

sum => ⌜1+2⌟

number => ⌜1⌟

number => ⌜2⌟

⌜1 + 2⌟

sum => ⌜1 + 2⌟

number => ⌜1⌟

number => ⌜2⌟插入的隐式的 <.ws> 调用并不完全适用于正则表达式中每一个空白的出现。特别是正则表达式开头的空白, 像在 :r 或 :s 这样的修饰符之后的空白,或者在开口花括号或开口圆括号之后的空白, 还有 &, && 和 || 之后的空白, 不会被替换为隐式 <.ws> 调用。一般的概念是, 规则解析匹配内部和匹配结尾的空白, 但不解析匹配开头的空白。

如果你使用 rule, 你必须意识到空白是重要的, 并且原子和它的量词之间的空白也有影响:

say "a a" ~~ rule { a+ }

say "a a" ~~ rule { a + }第一行打印的是「a」,而第二行打印的是「a a], 包括了最后一个 a。a 和 + 之间的空白被解释为 <.ws> 调用, 所以第二个 rule 等同于:

token { [a <.ws>]+ }最后, 你需要注意的是, 就像正则表达式中的任何部分一样 隐式调用 ws 也会使你的匹配失败:

say 'ab' ~~ rule { a b } # Output: Nil这里 a 和 b 之间的隐式 <.ws> 调用不匹配, 所以规则 a 作为整体也不匹配。

8.3. Grammars

命名正则表达式提供了第一层抽象, 但我们往往需要更多层的抽象。大多数高级编程语言都有模块、命名空间、类, 甚至三者都有, 以管理函数和方法的重用。

Raku 也提供了这些更高级别的抽象, 并使它们可用于正则表达式中。Grammar 是一个类, 它提供了一些调用正则表达式的工具。那么正则表达式是这个 grammar 中的方法:

grammar IPv4Address {

token byte {

\d ** 1..3

<?{ $/.Int <= 255 }>

}

token TOP {

<byte> ** 4 % '.'

}

}

my $str = '127.0.0.1';

if IPv4Address.parse($str) {

say join ', ', $<byte>.list;

# Output: 127, 0, 0, 1

}第一个 grammar 是用 grammar 关键字声明的, 后面是 grammar 的名称 IPv4Address。grammar 是一种自动添加类型为 Grammar[42] 的父类, 并提供了一些方法, 如 parse 和 subparse 等。

grammar 的主体由花括号分割。 在主体里面, 我们使用 regex 或 token 关键字声明正则表达式。请注意, 我们省略了声明前面的 my 声明符, 因为现在正则表达式是作用域属于 grammar 的方法。

parse 方法调用名为 TOP 的正则表达式, 并隐式将其锚定到字符串的开头和结尾。相比之下, subparse 方法仅锚定到字符串的开头。parse 和 subparse 方法都接收一个可选的, 命名参数规则, 你可以用它来调用 TOP 以外的正则表达式:

say IPv4Address.subparse($str, :rule<byte>); # Output: ⌜127⌟

say IPv4Address.parse($str, :rule<byte>); # Output: Nil这里 IPv4Address.parse($str, :rule<byte>) 失败了, 因为正则表达式 <byte> 不能匹配整个输入字符串, 并且 parse 隐式将正则表达式的结尾锚定到字符串的末尾。相反, subparse 匹配输入字符串的第一个数字。

在 grammar 内部, 调用同一 grammar 的另一个正则表达式, 其作用和外部一样; 带尖括号 :<byte>。但如果你想抑制捕获, 你必须使用一个点代替 & 符号: <.byte>。重命名也是一样, 因此 <octect=.byte> 会调用正则表达式 byte, 但产生一个名为 octect 的捕获。点(.)的使用类似于方法调用语法, 它也使用点号。

8.4. 使用 Grammars 重用代码

Raku 提供了两种重用面向对象代码的方法:继承和角色组合。因为 grammar 实际上是类, 所以这两种机制也适用于 grammar。

8.4.1. 继承

继承是一种特殊化的形式。如果你有一个通用的 grammar, 然后想一个经过一些调整的变体, 那么这个调整后的变体可以继承更通用的 grammar。

例如, 考虑 SQL 的 grammar, 即 结构化查询语言[43]。这种 grammar 是有标准的, 但有些实现是方言。MySQL 就是这样的一个例子, 它使用反引号而不是双引号来引用表名和列名。然后, MySQL 方言的 grammar 将从标准的 SQL grammar 中继承, 并覆盖用于解析表名和列名的正则表达式。

为了说明这个想法, 让我们只关注解析 SQL 列名。根据 SQL 标准规定, 它们要么是标识符, 要么是双引号字符串:

grammar StandardSQL {

regex TOP {

'SELECT' \s+ <name>

}

regex name {

<identifier>

| <quoted_name>

}

regex quoted_name {

\" <-["]>+ \"

}

regex identifier {

« <:alpha> \w* »

}

}

say StandardSQL.parse('SELECT salary');

say StandardSQL.parse('SELECT "monthly salary"');这两个解析都成功了, 并且它们产生了这样的输出:

⌜SELECT salary⌟

name => ⌜salary⌟

identifier => ⌜salary⌟

⌜SELECT "monthly salary"⌟

name => ⌜"monthly salary"⌟

quoted_name => ⌜"monthly salary"⌟如前所述, MySQL 使用反引号而不是双引号来引用标识符。与其重复整个 grammar, 我们可以编写一个继承自 StandardSQL 的 grammar MysqlSQL, 只覆盖正则表达式 quoted_name:

grammar MysqlSQL is StandardSQL {

regex quoted_name {

\` <-[`]>+ \`

}

}

say MysqlSQL.parse('SELECT `monthly salary`');这里 grammar 声明中的文本 "is StandardSQL" 定义了从 StandardSQL grammar 中继承。继承意味着, 如果在子类中调用一个正则表达式或方法, 而在子类中没有定义, 则会调用父类中同名的方法。

8.4.2. 角色组合

角色 - 在其他编程语言中也被称为 trait - 是指可以复制到类或 grammar 中的一块函数(例如方法和正则表达式)。这种复制称为组合。

角色组合非常适合从更小的, 独立的部分组装一个 grammar。例如, 解析数字和引号字符串是相当普遍的, 在解析 SQL、JSON 和几种类型的配置文件时, 这两个可能都是必要的。解析数字也适用在解析数学表达式:

role ParseInteger {

token unsigned { <[0..9]>+ }

token signed { ['+' | '-']? <unsigned> }

}

role ParseFloat does ParseInteger {

token escale { <[eE]> <unsigned> }

token float {

$<sign>=<[+-]>?

[

$<coeff> = [ <[0..9]>* '.' <unsigned> ] <escale>?

| $<coeff> = [ <unsigned> ] <escale>

]

}

}

grammar Sum does ParseFloat {

token number { <signed> | <float> }

rule TOP { <number> '+' <number> }

}

grammar JSON does ParseFloat {

token value {

<signed>

| <float>

# more options go here

}

# rest of the grammar here

}

say Sum.parse('2 + -4');这个例子显示了两个包含正则表达式的角色: role ParseInteger 有两个 token, 一个用于解析不带任何符号的整数(token unsigned), 一个用于解析可能带有 + 或 - 符号的整数。第二个角色, ParseFloat 通过声明 does ParseInteger 来使用第一个角色 。然后, 它声明一个 token float 来解析浮点数。

与继承不同, 角色组合在编译时检测名称冲突, 并强制你解决这些冲突。这使得多个角色可以安全地编译到同一个类中, 或者多个角色可以安全地编译到一个角色中。

8.5. Proto Regexes

假设你想为 JSON[44](也称为 JavaScript 对象表示法) 编写一个 grammar。json.org 的主页肯定会告诉你, 当解析一个值时, 你期望的是一个字符串、数字、对象、数组或字面量字符串、true、false 或 null。没问题, 你可以这样写:

grammar JSON {

token value {

| <string>

| <number>

| <object>

| <array>

| 'true'

| 'false'

| 'null'

}

# more tokens and rules go here

}这很管用, 但它的可扩展性并不是很好。假设你想解析一个扩展的 JSON 方言, 例如添加 2015-12-24 这样的无引号字符串形式的日期类型。你可以通过继承上一个例子中暗示的 JSON grammar 来实现, 编写一个 token date 来解析日期, 然后你必须覆盖 token value, 把父 grammar 中的所有备选项都列出来, 然后再列出你自己的。

这种重复不仅烦人, 容易出错, 而且还会使得同一个 grammar 无法进行多次修改。如果别人想编写另一个扩展, 添加不同类型的新值(比如说引用类型), 他们的扩展不会意识到你的扩展, 所以用户不能轻易地将它们混合在一起。

Raku 提供了一个解决这个问题的方法: proto regexes。原型正则表达式是一个正则表达式的集合, 它们一起构成了一个很大的备选项, 就像每个备选项都是由一个 | 来分隔一样。下面是我们将 JSON grammar 的一部分写成了原型正则表达式:

grammar JSON {

proto token value {*};

token value:sym<string> { <string> }

token value:sym<number> { <number> }

token value:sym<object> { <object> }

token value:sym<array> { <array> }

token value:sym<true> { <sym> }

token value:sym<false> { <sym> }

token value:sym<null> { <sym> }

# more tokens and rules go here

}行 proto token {*} 引入一个带有名称 value 的原型正则表达式(或 token)。这就指示 Raku 将有更多的名称为 value 的正则表达式, 并加上一些小的补充。这些小的补充的形式是: sym <SOMETHING>, 帮助你和编译器将这些正则表达式分开。这种正则表达式的主体可以是你所知道的任何东西, 所以我们可以在这里实现, 而不是在 token value:sym<number> 里面调用 token number:

token value:sym<number> {

'-'?

[ 0 | <[1..9]> <[0..9]>* ]

[ \. <[0..9]>+ ]?

[ <[eE]> [\+|\-]? <[0..9]>+ ]?

}在每个单独候选项中, :sym<…> 里面的名字可用作特殊符号 <sym> 使用。所以不要写成:

token value:sym<null> { 'null' }我们可以这样写:

token value:sym<null> { <sym> }以避免名称的重复。

让我们把这个例子稍作删减, 变成可运行的代码:

grammar JSONValue {

proto token value {*};

token value:sym<true> { <sym> }

token value:sym<false> { <sym> }

token value:sym<null> { <sym> }

token TOP { <value> }

}这是一个非常简约的 grammar, 只解析 JSON 值 true、false 和 null。我们的扩展使其解析 ISO 8601 格式的日期, 可以是一个添加了候选 token 的简单角色:

role DateValue {

token value:sym<date> {

<[0..9]>**4 '-' <[0..9]>**2 '-' <[0..9]>**2

}

}我们不需要在角色中声明 proto token value, 因为它会被混合到包含此声明的 grammar 中。

为了使用 DateValue 扩展, 我们可以基于 JSONValue 和角色生成一个 grammar:

grammar JSONValueWithDate is JSONValue does DateValue { };

for <true null 2015-12-24 42> -> $str {

say $str, ': ', ?JSONValueWithDate.parse($str);

}这使用了 JSONValue 的继承, 也使用了 DateValue 的角色组合来生成一个新的 grammar, 现在可以解析 true、false、null 和 date 值。它产生了这样的输出:

true: True

null: True

2015-12-24: True

42: False正则表达式外的 ? 运算符强制使用布尔上下文, 这就是为什么我们在输出中看到 True 和 False, 而不是 Match 对象和 Nil。

我们可以避免显式地创建 grammar JSONValueWithDate, 而只需使用 but 操作符就地组合一个匿名的 grammar:

for <true null 2015-12-24 42> -> $str {

say $str, ': ', ?(JSONValue but DateValue).parse($str);

}but 操作符在左侧创建一个类型或对象的副本, 对其应用角色, 并返回结果。

这两种方法都可以用来给 grammar 添加多个扩展:

role IntegerValue {

token value:sym<integer> { <[0..9]>+ }

}

my $grammar = (JSONValue but DateValue) but IntegerValue;

for <true null 2015-12-24 42> -> $str {

say $str, ': ', ?$grammar.parse($str);

}现在, 由 JSONValue、DateValue 和 IntegerValue 组成的 grammar 可以解析所有四个示例输入字符串。扩展角色不需要考虑其他角色; 它们是可以自由组合的。

解析 JSON 子集的例子来自 JSON::Tiny[45] 模块, 该模块使用可管理的 Raku grammar[46] 解析 JSON。我们越来越接近于能够创建具有许多实际应用的可扩展 grammar。

8.6. 总结

Raku 提供了命名正则表达式以方便重用。为了简化词法分析, token 和 rule 关键字禁用了回溯, rule 关键字还会隐式解析空白。

由于正则表达式可以用作方法, 所以可以用面向对象编程中的强大技术来管理和重用正则表达式。Grammar 对正则表达式进行分组、继承和角色组合使它们可以被重用。

最后, proto regexes 确保了扩展可以以自然的方式进行, 而不会干扰 grammar 中相同位置的其他潜在扩展。

9. 使用 Grammar 进行解析

Grammar 是众所周知的用于解析的瑞士军刀[47]。

在本章中, 我们将对它们进行更详细的探讨。最重要的是, 我们将讨论如何利用它们的力量。

9.1. 理解 Grammar

Grammar 实现了一种自上而下的解析方法。解析的入口点, 通常是正则表达式 TOP, 了解粗粒度结构和调用更多的正则表达式, 从而进入血淋淋的细节。递归也会涉及其中。例如, 如果你解析一个数学表达式, 则项可以是一对括号内的任意表达式。

这是一种自上而下的结构, 或者更准确地说是一种递归下降解析器[48]。如果不涉及回溯, 我们将其称为预测性解析器, 因为在字符串中的每个位置, 我们都知道我们要找的是什么 - 我们可以预测下一个 token 是什么(即使我们只能预测它可能是一组候选者之一)。

所得到的匹配树在结构上完全对应于 grammar 中的正则表达式的调用结构。让我们考虑一下解析一个数学表达式, 它只包含运算符 *, + 和用于分组的括号:

grammar MathExpression {

token TOP { <sum> }

rule sum { <product>+ % '+' }

rule product { <term>+ % '*' }

rule term { <number> | <group> }

rule group { '(' <sum> ')' }

token number { \d+ }

}

say MathExpression.parse('2 + 4 * 5 * (1 + 3)');从 grammar 本身来看, 你已经可以看到递归的潜力: sum 调用 product, product 调用 term, term 调用 group, term 再调用 sum。这样就可以对任意深度的嵌套表达式进行解析。

运行前面的示例, 会产生以下匹配对象:

「2 + 4 * 5 * (1 + 3)」

sum => 「2 + 4 * 5 * (1 + 3)」

product => 「2 」

term => 「2 」

number => 「2」

product => 「4 * 5 * (1 + 3)」

term => 「4 」

number => 「4」

term => 「5 」

number => 「5」

term => 「(1 + 3)」

group => 「(1 + 3)」

sum => 「1 + 3」

product => 「1 」

term => 「1 」

number => 「1」

product => 「3」

term => 「3」

number => 「3」如果你想知道某个特定的数字是如何解析的, 可以按照路径回溯, 查找当前行上面少缩进的行, 比如说, 数字 1 是通过 token number 解析的, 从 term 调用, 从 product 调用, 以此类推。

我们可以通过从 token number 中引发异常来验证:

token number {

(\d+)

{ die "how did I get here?" if $0 eq '1' }

}这确实显示了回溯中的调用链, 最直接的上下文在最上面:

how did I get here?

in regex number at bt.p6 line 9

in regex term at bt.p6 line 5

in regex product at bt.p6 line 4

in regex sum at bt.p6 line 3

in regex group at bt.p6 line 6

in regex term at bt.p6 line 5

in regex product at bt.p6 line 4

in regex sum at bt.p6 line 3

in regex TOP at bt.p6 line 2

in block <unit> at bt.p6 line 13这个 grammar 只使用 token 和 rule, 所以没有涉及回溯, 而且这个 grammar 是一个预测性解析器。这是相当典型的。许多 grammar 在不涉及回溯的情况下, 或者只涉及到几个地方的回溯, 都能正常工作。

9.1.1. 递归下降解析和优先级

MathExpression grammar 有两个结构相同的规则:

rule sum { <product>+ % '+' }

rule product { <term>+ % '*' }相反, 我们可以这样写:

rule expression { <operator>+ % <term> }

token operator { '*' | '+' }甚至使用上一章中讨论过的 proto token 构造来解析不同的运算符。我之所以选择第一种比较重复的方法, 是因为它使匹配结构与运算符 * 和 + 的优先级相对应。

在计算数学表达式 1 + 2 * 5 时, 数学家和大多数编程语言都会首先计算 2 * 5, 因为 * 运算符的优先级比 + 更高。然后再将结果代入表达式中, 导致 1 + 10, 最后得到 11 作为结果。

当用第一版 grammar 解析这样的表达式时, 解析树的结构表达了这种的分组: 它的顶层是一个单一的 sum, 操作数为 1 和 2 * 5。

这是做是有代价的: 我们需要为每个优先级分别设置一个单独的规则和名称, 而且由此产生的匹配对象的嵌套, 每个优先级至少有一个级别。此外, 以后再增加更多的优先级也不是一件小事, 而且很难用通用的方式来做。如果你不愿意接受这些成本, 你可以使用扁平化的模型, 用一个单一的 token 来解析所有的运算符。如果这时你需要一个结构以反映优先级的方式, 你可以编写将列表转换为树的代码。这通常称为运算符优先级解析器[49]。

9.1.2. 左递归和其它陷阱

为了避免无限递归, 你必须注意每一个可能的递归循环使游标位置前进至少一个字符。在 MathExpression grammar 中, 唯一可能的递归循环是 sum → product → term → group → sum, 而 group 只有在消耗一个初始的开括号 ( 时才匹配。

如果递归不消耗字符, 则称为左递归, 需要特殊的语言支持, 这是 Raku 所不提供的。一个典型的例子是:

token a { <a>? 'a' }它本可以与正则表达式 a+ 匹配相同的输入, 但是无限循环而不处理。

一个常见的避免左递归的技术是有一个结构, 在这个结构中, 你可以将正则表达式从通用(这里是 sum)到特定(number)进行排序。你只需要小心翼翼, 当一个正则表达式偏离这个顺序时, 检查消耗的字符(例如, group 调用 sum)。

另一个潜在的无限循环的来源是当你量词化一个可以匹配空字符串的化正则表达式时。这可能发生在解析一个实际允许空的语言时。例如, 在 UNIX shell 中, 你可以通过潜在的右侧留空来分配变量:

VAR1=value

VAR2=在为 UNIX shell 命令编写 grammar 时, 可能会很想写一个可能匹配空字符串的 token string { \w* }。在允许有一个以上的字符串文字的情况下, <string>+ 可能会挂起, 因为有效的正则表达式 [\w*]+ 会无限次地尝试匹配一个零宽度的字符串。

一旦你意识到这个问题, 解决方法很简单: 更改 token, 使其不允许空字符串(token string { \w+ }), 并明确地处理允许空字符串的情况:

token assignment {

<variable> '=' <string>?

}9.2. 从简单开始

即使 grammar 是从上而下地工作, 但开发一个 grammar 也是自下而上地工作。Grammar 的整体结构通常从一开始并不明显, 但你通常对终端 token 有一个很好的想法: 那些直接匹配文本而不调用子规则的 token。在前面解析数学表达式的例子中, 你可能从一开始就不知道如何安排解析 sum 和 product 的规则, 但很可能你知道你在某个时候必须解析一个数字, 所以你可以从写作开始:

grammar MathExpression {

token number { \d+ }

}这样做虽然不多, 但也不是很复杂, 这也是克服程序员在遇到新问题领域的挑战时有时会遇到的写作障碍的好方法。当然, 只要你有了 token, 就可以开始写一些测试了:

grammar MathExpression {

token number { \d+ }

}

multi sub MAIN(Bool :$test!) {

use Test;

plan 2;

ok MathExpression.parse('1234', :rule<number>),

'<number> parses 1234';

nok MathExpression.parse('1+4', :rule<number>),

'<number> does not parse 1+4';

}现在, 你可以开始构建更复杂的表达式:

grammar MathExpression {

token number { \d+ }

rule product { <number>+ % '*' }

}

multi sub MAIN(Bool :$test!) {

use Test;

plan 5;

ok MathExpression.parse('1234', :rule<number>),

'<number> parses 1234';

nok MathExpression.parse('1+4', :rule<number>),

'<number> does not parse 1+4';

ok MathExpression.parse('1234', :rule<product>),

'<product> can parse a simple number';

ok MathExpression.parse('1*3*4', :rule<product>),

'<product> can parse three terms';

ok MathExpression.parse('1 * 3', :rule<product>),

'<product> and whitespace';

}在测试的早期就加入空格是值得的。前面的例子看起来很无辜, 但最后的测试实际上是失败的。在 1 和 * 之间没有匹配空格的规则。在 <number> 和 + 量词之间的正则表达式中添加一个空格, 会使测试再次通过, 因为空格插入了一个隐式的 <.ws> 调用。

如果你开始时真的很简单, 并尽快抓住它们, 这些细微之处就很容易被抓住。相反, 如果你屈服于从上到下写下整个 grammar 的诱惑, 你可能会花很多时间来调试为什么一些看似简单的东西, 比如一个额外的空格会导致解析失败。

9.3. 组装完整的 Grammar

一旦你写出了基本的用于词法分析的 token, 你就可以进展到组合 token 了。通常, token 不会在其匹配的边界处解析空格, 所以组合它们的规则就是这样做的。

在上一节中的 MathExpression 例子中, 规则 product 直接调用 number, 尽管我们现在知道最终版本使用了一个中间步骤 - 规则术语, 它也可以解析括号中的表达式。引入这个额外的步骤并不会使测试无效。

我们已经编写了 product, 因为它在早期版本中匹配的字符串仍然匹配。当你开始使用一个处理语言的子集的 grammar 时, 引入更多的层数就会自然而然地发生, 而这个子集是你后来来扩展的。

9.4. 调试 Grammar

正则表达式或 grammar 有两种失败模式: 当它不应该匹配时, 它匹配了(误报), 或者当它应该匹配时, 它没有匹配(漏报)。通常, 误报模式比较容易理解, 因为你可以检查结果的匹配对象, 看看哪一个正则表达式匹配了字符串的哪一部分。

有一个方便的工具来调试漏报: Grammar::Tracer 模块。如果你在一个包含 grammar 的文件中加载该模块, 运行该 grammar 会产生诊断信息, 可以帮助你找出匹配出错的地方。

请注意, 这只是为开发者提供的诊断工具; 如果你想给终端用户提供更好的错误信息, 请阅读第十一章的改进建议。

你需要安装 Raku 模块 Grammar::Debugger, 其中也包含 Grammar::Tracer。如果你使用的是 moritzlenz/raku-regex-alpine docker 镜像, 这已经为你完成了。如果你通过其它方式安装了 Raku, 你需要在命令行上运行:

zef install Grammar::Debugger如果尚未安装 zef, 请按照 zef 在 GitHub 页面的安装说明进行安装[50]。

让我们来看看 Tadeusz Sośnierz 所编写的 Raku 模块 Config::INI[51]。它包含以下 grammar[52](这里稍作修改):

grammar INI {

token TOP {

^

<.eol>*

<toplevel>?

<sections>*

<.eol>*

$

}

token toplevel { <keyval>* }

token sections { <header> <keyval>* }

token header { ^^ \h* '[' ~ ']' $<text>=<-[ \] \n ]>+ \h* <.eol>+ }

token keyval { ^^ \h* <key> \h* '=' \h* <value>? \h* <.eol>+ }

regex key { <![#\[]> <-[;=]>+ }

regex value { [ <![#;]> \N ]+ }

token eol { [ <[#;]> \N* ]? \n }

}假设我们想了解为什么它不能解析下面这段输入文本:

a= b

[foo]

c: d所以, 在 grammar 之前, 我们插入一行:

use Grammar::Tracer;然后, 添加一小段代码, 调用该 grammar 的 .parse 方法:

INI.parse(q:to/EOF/);

a= b

[foo]

c: d

EOF这样会产生一个相当大但信息量很大的输出。

每个条目都由一个正则表达式的名称组成, 比如 TOP 或 eol(表示行的尽头), 然后是它所调用的正则表达式的缩进输出。在每一个正则表达式后面都有一个星号(*)和 MATCH(匹配), 后面跟着正则表达式匹配的字符串片段, 如果正则表达式失败则为 FAIL。

让我们逐条看一下输出, 即使它是以一个大块的形式出现。

这告诉我们, TOP 调用了 eol, 但匹配失败了。对 eol 的调用使用 * 来量词化, 这不会导致 TOP 的匹配失败。 然后 TOP 调用 key, 匹配文本 "a" value 匹配文本 "b"。然后 eol 正则表达式继续匹配换行符, 第二次尝试失败(因为一行中没有两个换行符)。这会导致初始的 keyval token 匹配成功。第二次调用 keyval 匹配很快就成功了(在调用 key 的时候)。然后, token toplevel 的匹配成功进行, 消耗了字符串 "a = b\n"。

到目前为止, 这一切看起来都和预期的一样。现在我们来看看第二大块的输出:

TOP 接下来调用 section, 其中 token header 成功匹配了字符串 "[foo]\n"。然后, keyval 调用 key, 匹配了整行 "c:d\n"。等等, 这不对劲吧, 我们可能会期望 key 只匹配 c。我当然不会想到它会匹配结尾的换行符。因为输入中没有等号, 导致正则表达式引擎根本不会调用正则表达式 value。但由于 keyval 又是用星 * 量词进行量化, 所提调用的正则表达式部分的匹配成功只是匹配到了标题 "[foo]\n"。

下面是 Grammar::Tracer 输出的最后一部分:

从这里开始就是 FAILs。第二次调用 section 再次尝试解析一个标题, 但它的下一个输入仍然是 "c:d\n", 所以它失败了, 就像 token TOP 中的字符串末尾锚点 $ 一样, 方法解析中的整体匹配失败。

所以我们已经知道正则表达式 key 匹配了整行 c:d\n, 但是由于后面没有等号(=), token keyval 无法解析这一行。由于没有其他的正则表达式(特别是没有 header)与之匹配, 这就是匹配失败的地方。

从这个例子中我们可以看到, 尽管我们必须仔细查看它的输出来定位, 但 Grammar::Tracer 可以让我们确定解析失败的位置。当你在终端上运行它时, 你会自动得到彩色的输出, FAIL 是红色的, MATCH 是绿色的, 而 token 名则是白色的(而不是通常的灰色)输出。这使得从底部(失败的匹配通常会留下红色的 FAIL)到后面的成功匹配, 然后在匹配和失败之间的边界附近寻找。

由于调试会带来很大的心理负担, 而且 Grammar::Tracer 的输出往往会迅速增长, 所以一般建议将失败的输入减少到最小的样本。在前面描述的案例中, 我们可以删除输入字符串的第一行, 并保存十行 Grammar::Tracer 的输出来查看。

9.5. 解析空白和注释

如前所述, 解析不重要的空白的常用方法是调用 <.ws>, 通常是通过在规则中使用空白处来隐式地解析。默认的 ws 实现, <!ww>s*, 适用于多种语言, 但它有其局限性。

在很多文件格式和计算机语言中, 有大量的空白空间会被 <.ws> 占据。这些文件包括 INI 文件(其中换行通常表示一个新的键/值对)、Python 和 YAML(其中缩进用于分组)、CSV(其中换行表示新的记录)和 Makefile(其中缩进需要使用制表符)。

在这些情况下, 最好的做法是在自己的 grammar 中覆盖 ws, 只匹配不重要的空白。让我们来看看第二个最小化的 INI 解析器, 它是在上一节中描述的基础上独立开发的。

grammar INIFile {

token TOP { <section>* }

token section {

<header>

<keyvalue>*

}

rule header {

'[' <-[ \] \n ]>+ ']' <.eol>

}

rule keyvalue {

^^

$<key>=[\w+]

<[:=]>

$<value>=[<-[\n;#]>*]

<.eol>

}

token ws { <!ww> \h* }

token eol {

\n [\h*\n]*

}

}这个解析器可以解析像这样的简单的 INI 配置文件:

[db]

driver: mysql

host: db01.example.com

port: 122

username: us123

password: s3kr1t请注意这个 grammar 是如何使用两个路径来解析空白的: 一个自定义的 ws token, 它只匹配水平的空白和制表符, 另一个单独的 token eol, 它匹配(重要的)断行符。eol token 也会吞噬其他仅由空格组成的行。

如果一种语言支持注释, 而你不希望它们出现在你的解析树中, 你可以在你的 ws 标记中, 或者在 eol(或你的等价物)中解析它们。具体是哪一种, 要看注释在什么地方被允许。在 INI 文件中, 它们只允许在键/值对之后或单独的一行中出现, 所以 eol 是最合适的地方。相比之下, SQL 允许在每一个允许空格的地方都有注释, 所以在 ws 中解析它们是很自然的。

# comment parsing for SQL:

token ws { <!ww> \s* [ '--' \N* \n ]* }

# comment parsing for INI files:

token eol { [ [ <[#;]> \N* ]? \n ]+ }9.6. 保存状态

一些比较有趣的数据格式和语言需要解析器来存储东西(至少是暂时的), 以便能够正确解析它们。C 语言和其他受其语法启发的语言(如 C++ 和 Java)就是一个例子。这些语言允许变量声明的形式为变量=初始值, 就像这样。

int x = 42;这是有效的语法, 但前提是第一个单词是类型名。相反, 这将是无效的, 因为 x 不是一个类型:

int x = 42; x y = 23;从这些例子中可以清楚地看出, 解析器必须有一个它所知道的所有类型的记录。因为用户也可以在代码文件中声明类型, 所以解析器必须能够更新这个记录。

许多语言还要求在引用符号(变量、类型和函数)之前必须声明这些符号。这也需要 grammar 来记录哪些符号已经声明了, 哪些没有声明。这条记录了什么已经声明了什么(以及什么是类型或不是类型, 可能还有其他的元信息)的记录被称为符号表。

与其解析完整的 C 语言编程语言, 不如让我们考虑一个最小化的语言, 它只允许对数字列表和变量进行赋值。

a= 1

b= 2

c = a, 5, b如果我们不强加声明规则, 那么写一个 grammar 就相当容易了:

grammar VariableLists {

token TOP { <statement>* }

rule statement { <identifier> '=' <termlist> \n }

rule termlist { <term> * % ',' }

token term { <identifier> | <number> }

token number { \d+ }

token identifier { <:alpha> \w* }

token ws { <!ww> \h* }

}现在我们要求只有在变量被赋值后才能使用, 那么下面的输入将是无效的, 因为 b 在第二行中没有声明, 但在第二行中使用了 b。

a= 1

c = a, 5, b

b= 2为了维护一个符号表, 我们需要三个新的元素: 符号表的声明, 一些代码, 当赋值被解析后, 将变量名添加到符号表中, 最后是检查我们在术语表中遇到变量时, 是否已经声明了变量。

grammar VariableLists {

token TOP {

:my %*SYMBOLS;

<statement>*

}

token ws { <!ww> \h* }

rule statement {

<identifier>

{ %*SYMBOLS{ $<identifier> } = True }

'=' <termlist>

\n

}

rule termlist { <term> * % ',' }

token term { <variable> | <number> }

token variable {

<identifier>

<?{ %*SYMBOLS{ $<identifier> } }>

}

token number { \d+ }

token identifier { <:alpha> \w* }

}在 token TOP 中, :my %SYMBOLS 声明了一个变量。正则表达式中的声明以冒号(:)开始, 以分号(;)结束。在这之间, 它们看起来就像 Raku 中的普通声明一样。%sigil 表示变量是一个散列 - 字符串键与值之间的映射。而 使它成为一个动态变量 - 一个不限于当前作用域的变量, 也可以被当前作用域中调用的代码(或者是正则表达式, 也是代码)看到。因为这是一个非常大的作用域, 所以习惯上选择大写字母的变量。

第二部分, 将符号添加到符号表中, 在规则语句中发生。

rule statement {

<identifier>

{ %*SYMBOLS{ $<identifier> } = True }

'=' <termlist>

\n

}在花括号里面是普通(非正则表达式)的 Raku 代码, 所以我们可以用它来处理 %*SYMBOLS 这个散列。表达式 $<identifier> 访问变量名称的捕获[53]。因此, 如果这条规则解析了变量 a, 那么这条语句将 %*SYMBOLS{'a'} 设置为 %*SYMBOLS{'a'}。= True。

代码块的位置是相关的。把它放在 termlist 调用之前, 意味着在解析 termlist 时已经知道这个变量, 所以它接受像 a = 2, a 这样的输入, 如果我们先调用 termlist, 这样的输入会被拒绝。

说到拒绝, 这部分发生在 token variable 中, term 现在调用新的 token variable(之前直接调用 identifier), 变量验证之前已经声明了标识符。

token term { <variable> | <number> }

token variable {

<identifier>

<?{ %*SYMBOLS{ $<identifier> } }>

}你可能还记得在前面的例子中, <?{…}> 执行了一段 Raku 代码, 如果返回的值为 false, 则解析失败。如果 $<identifier> 不在 %*SYMBOLS 中, 就会出现这种情况。这时, token 的非回溯性就很重要了。如果被解析的变量是 abc, 而变量 a 在 %*SYMBOLS 中, 那么回溯将尝试对 <identifier> 进行更短的匹配, 直到匹配到 a, 然后成功。[54]

因为 %*SYMBOLS 是在 token TOP 中声明的, 所以当你尝试从 grammar 之外调用 TOP 以外的规则时, 你必须重复这个声明。如果没有像 my %*SYMBOLS; 这样的声明, 那么像:

VariableLists.parse('abc', rule => 'variable');死于:

Dynamic variable %*SYMBOLS not found9.6.1. 使用动态变量实现词法作用域

许多编程语言都具有词法作用域的概念。作用域是指程序中可以看到一个符号的区域。如果作用域完全由文本的结构决定(而不是程序的运行时特征), 我们称作用域为词法范围。

作用域通常是可以嵌套的。在一个作用域中声明的变量在这个作用域中, 以及所有内部的、嵌套的作用域中都是可见的(除非一个内部的作用域声明了一个同名的变量, 在这种情况下, 内部的声明隐藏了外部的变量)。

回到列表和赋值的玩具语言, 我们可以引入一对大括号来表示一个新的作用域, 这样就有效了。

a= 1

b= 2

{

c = a, 5, b

}但是下一个例子是无效的, 因为它只在内部作用域中声明了 b, 所以在外部作用域中是不可见的:

a = 1

{

b = 2

}

c = a, 5, b为了在 grammar 中实现这些规则, 我们可以利用一个重要的观察: grammar 中的动态作用域对应于它所解析的文本中的词法作用域。如果我们有一个正则表达式块, 它既可以解析一个作用域的分界符, 也可以解析该作用域内的东西, 那么它的动态作用域就被限制在它所调用的所有正则表达式(直接和间接), 这也是它在输入文本中匹配的词法作用域。

下面我们来看看如何实现动态作用域。

grammar VariableLists {

token TOP {

:my %*SYMBOLS;

<statement>*

}

token ws { <!ww> \h* }

token statement {

| <declaration>

| <block>

}

rule declaration {

<identifier>

{ %*SYMBOLS{ $<identifier> } = True; }

'=' <termlist>

\n

}

rule block {